Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

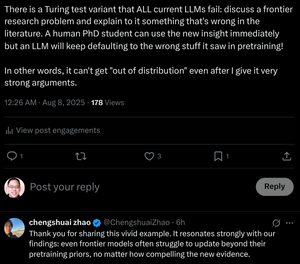

"Selbst Grenzmodelle haben Schwierigkeiten, über die Vortrainingsprioritäten hinaus zu aktualisieren, egal wie überzeugend die neuen Beweise sind."

Wir bilden Doktoranden aus, um dies zu tun! Können Transformer das tun, ohne ihre Gewichte zu ändern?

Top

Ranking

Favoriten