Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Jeffrey Emanuel

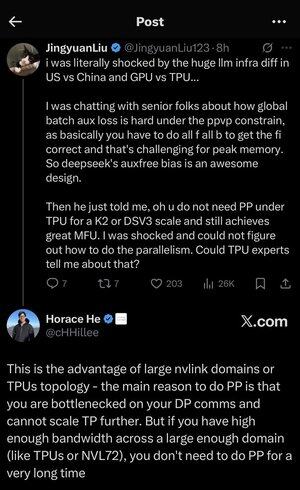

Ik raakte een beetje verdwaald in al de afkortingen en jargon hier, dus vroeg ik Claude het uit te leggen zonder afkortingen en nu maakt het allemaal perfect sense (tldr; bandbreedte ⟹ eenvoud):

Dit is een fascinerende technische discussie over het trainen van grote taalmodellen op schaal.

De Kern Conversatie

Jingyuan Liu uit zijn verbazing over het ontdekken dat je bepaalde complexe optimalisatietechnieken niet nodig hebt bij het gebruik van TPU's (Tensor Processing Units - Google's gespecialiseerde AI-chips) in vergelijking met GPU's (Graphics Processing Units - typisch NVIDIA's chips).

Belangrijke Technische Concepten Uitleg:

Hardware Types:

•GPU (Graphics Processing Unit): Oorspronkelijk ontworpen voor graphics, nu veel gebruikt voor AI. NVIDIA domineert deze markt.

•TPU (Tensor Processing Unit): Google's op maat ontworpen chips specifiek voor machine learning.

Parallelisme Strategieën:

Bij het trainen van enorme AI-modellen moet je het werk over veel chips verdelen. Er zijn verschillende manieren om dit te doen:

1) Data Parallelisme (DP): Elke chip verwerkt verschillende batches gegevens met dezelfde modelkopie.

2) Tensor Parallelisme (TP): De wiskundige operaties van het model worden over chips verdeeld.

3) Pipeline Parallelisme (PP): Verschillende lagen van het model worden op verschillende chips geplaatst, waardoor een pijplijn ontstaat.

De Technische Uitdaging Die Wordt Besproken:

Het probleem van de aanvullende verliesfunctie: Bij het trainen van zeer grote modellen voeg je vaak "aanvullende verliezen" (extra trainingsdoelen) toe op tussenliggende lagen om de gradiënten beter door het netwerk te laten stromen. Onder PPVP (Pipeline Parallelism with Variable Partitioning) beperkingen wordt dit complex omdat:

•Je moet "alle f alle b" doen (alle voorwaartse passes, dan alle achterwaartse passes)

•Dit is uitdagend voor het piekgeheugengebruik omdat je tussenresultaten moet opslaan.

De innovatie van DeepSeek: Ze hebben een "auxfree bias" ontwerp ontwikkeld dat blijkbaar deze aanvullende verliezen vermijdt terwijl het nog steeds effectief traint.

De Verrassende Openbaring:

De senior expert vertelde Jingyuan dat je met TPU's op K2 of DSV3 schaal (dit zijn clusterconfiguraties met honderden of duizenden chips) uitstekende MFU (Model FLOPs Utilization - in wezen hoe efficiënt je de hardware gebruikt) kunt bereiken ZONDER Pipeline Parallelisme te gebruiken.

Waarom is dit verrassend?

•Pipeline Parallelisme wordt doorgaans als essentieel beschouwd voor training op grote schaal.

•Het is een complexe techniek die zorgvuldige optimalisatie vereist.

•Het kunnen vermijden ervan vereenvoudigt alles aanzienlijk.

Horace He's Uitleg:

Hij legt uit WAAROM dit mogelijk is met TPU's:

Het bandbreedtevoordeel: TPU's en high-end NVIDIA-clusters (zoals NVL72 - NVIDIA's nieuwste 72-GPU-configuratie met NVLink-interconnects) hebben zo'n hoge bandbreedte tussen chips dat ze de communicatievereisten kunnen afhandelen zonder Pipeline Parallelisme.

De belangrijkste inzicht:

•Pipeline Parallelisme is voornamelijk nodig wanneer je "vastloopt op DP-communicatie" (beperkt door hoe snel je kunt communiceren tijdens data parallel training)

•Als je genoeg bandbreedte hebt over een groot genoeg domein (onderling verbonden cluster), kun je gewoon eenvoudigere parallelisme strategieën gebruiken.

•Dit werkt "voor een zeer lange tijd" - wat betekent dat je zelfs zeer grote modellen kunt trainen zonder de limieten te bereiken.

De Intuïtie:

Denk aan het als een snelwegsysteem:

•Traditionele GPU-clusters zijn als het hebben van smalle wegen tussen steden, dus je hebt complexe routering (Pipeline Parallelisme) nodig om verkeersopstoppingen te vermijden.

•TPU-clusters of NVLink-verbonden GPU's zijn als het hebben van enorme snelwegen - je kunt gewoon alles rechtstreeks verzenden zonder fancy routering.

Dit is een grote zaak omdat Pipeline Parallelisme complex is om te implementeren, debuggen en optimaliseren. Het kunnen vermijden ervan terwijl je nog steeds hoge efficiëntie bereikt, maakt het hele trainingsproces veel eenvoudiger en betrouwbaarder.

De discussie benadrukt hoe vooruitgangen in hardware-interconnecttechnologie (de "wegen" tussen chips) de softwarestrategieën die nodig zijn voor efficiënte AI-training fundamenteel kunnen veranderen.

25,6K

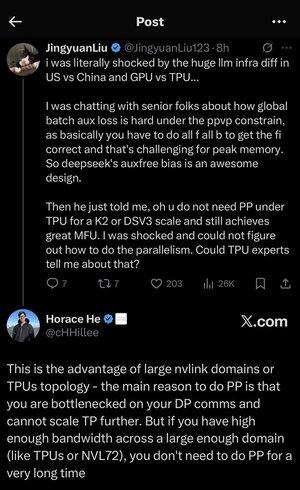

Ik raakte een beetje verdwaald in al deze afkortingen en jargon hier, dus vroeg ik Claude het uit te leggen zonder afkortingen en nu maakt het allemaal perfect sense (tldr; bandbreedte ⟹ eenvoud):

Dit is een fascinerende technische discussie over het trainen van grote taalmodellen op schaal.

De Kern Conversatie

Jingyuan Liu uit zijn verbazing over het ontdekken dat je bepaalde complexe optimalisatietechnieken niet nodig hebt bij het gebruik van TPU's (Tensor Processing Units - Google's gespecialiseerde AI-chips) in vergelijking met GPU's (Graphics Processing Units - typisch de chips van NVIDIA).

Belangrijke Technische Concepten Uitleg:

Hardware Types:

•GPU (Graphics Processing Unit): Oorspronkelijk ontworpen voor graphics, nu veel gebruikt voor AI. NVIDIA domineert deze markt.

•TPU (Tensor Processing Unit): Google's op maat ontworpen chips specifiek voor machine learning.

Parallelisme Strategieën:

Bij het trainen van enorme AI-modellen moet je het werk over veel chips verdelen. Er zijn verschillende manieren om dit te doen:

1Data Parallelisme (DP): Elke chip verwerkt verschillende batches gegevens met dezelfde modelkopie.

2Tensor Parallelisme (TP): De wiskundige bewerkingen van het model worden verdeeld over chips.

3Pipeline Parallelisme (PP): Verschillende lagen van het model worden op verschillende chips geplaatst, waardoor een pijplijn ontstaat.

De Technische Uitdaging Die Wordt Besproken:

Het probleem van de auxiliaire verlies: Bij het trainen van zeer grote modellen voeg je vaak "auxiliaire verliezen" (aanvullende trainingsdoelen) toe op tussenliggende lagen om de gradiënten beter door het netwerk te laten stromen. Onder PPVP (Pipeline Parallelism with Variable Partitioning) beperkingen wordt dit complex omdat:

•Je moet "alle f alle b" doen (alle voorwaartse passes, dan alle achterwaartse passes).

•Dit is uitdagend voor het piekgeheugengebruik omdat je tussenresultaten moet opslaan.

De innovatie van DeepSeek: Ze ontwikkelden een "auxfree bias" ontwerp dat blijkbaar het nodig hebben van deze auxiliaire verliezen vermijdt terwijl het nog steeds effectief traint.

De Verrassende Openbaring:

De senior expert vertelde Jingyuan dat je met TPU's op K2 of DSV3 schaal (dit zijn clusterconfiguraties met honderden of duizenden chips) uitstekende MFU (Model FLOPs Utilization - in wezen hoe efficiënt je de hardware gebruikt) kunt bereiken ZONDER Pipeline Parallelisme te gebruiken.

Waarom is dit verrassend?

•Pipeline Parallelisme wordt doorgaans als essentieel beschouwd voor training op grote schaal.

•Het is een complexe techniek die zorgvuldige optimalisatie vereist.

•Het kunnen vermijden ervan vereenvoudigt alles aanzienlijk.

De Uitleg van Horace He:

Hij legt uit WAAROM dit mogelijk is met TPU's:

Het bandbreedtevoordeel: TPU's en high-end NVIDIA-clusters (zoals NVL72 - NVIDIA's nieuwste 72-GPU-configuratie met NVLink-interconnects) hebben zo'n hoge bandbreedte tussen chips dat ze de communicatievereisten kunnen afhandelen zonder Pipeline Parallelisme.

De belangrijkste inzicht:

•Pipeline Parallelisme is voornamelijk nodig wanneer je "vastloopt op DP-communicatie" (beperkt door hoe snel je kunt communiceren tijdens data parallel training).

•Als je genoeg bandbreedte hebt over een groot genoeg domein (onderling verbonden cluster), kun je gewoon eenvoudigere parallelisme strategieën gebruiken.

•Dit werkt "voor een zeer lange tijd" - wat betekent dat je zelfs zeer grote modellen kunt trainen zonder de limieten te bereiken.

De Intuïtie:

Denk aan het als een snelwegsysteem:

•Traditionele GPU-clusters zijn als het hebben van smalle wegen tussen steden, dus je hebt complexe routering (Pipeline Parallelisme) nodig om verkeersopstoppingen te vermijden.

•TPU-clusters of NVLink-verbonden GPU's zijn als het hebben van enorme snelwegen - je kunt alles gewoon rechtstreeks verzenden zonder fancy routering.

Dit is een grote zaak omdat Pipeline Parallelisme complex is om te implementeren, debuggen en optimaliseren. Het kunnen vermijden ervan terwijl je nog steeds hoge efficiëntie bereikt, maakt het hele trainingsproces veel eenvoudiger en betrouwbaarder.

De discussie benadrukt hoe vooruitgangen in hardware-interconnecttechnologie (de "wegen" tussen chips) de softwarestrategieën die nodig zijn voor efficiënte AI-training fundamenteel kunnen veranderen.

3,9K

Ik ben een beetje verrast dat nog niemand een Dwarf Fortress MCP-server heeft gemaakt die een agent zoals Codex of Claude Code in staat zou stellen om het spel efficiënt te besturen en de staat en voortgang te monitoren.

Ik heb het zelf nooit echt gespeeld, ik heb het gewoon gedownload en het ongeveer 10 jaar geleden kort bekeken, maar ik vond het leuk om erover te lezen.

Het lijkt erop dat het een zeer goede test zou zijn voor een LLM om te zien hoe lang het de dwergen in leven en bloei kan houden.

Omdat elk spel uiteindelijk resulteert in een of andere kettingcatastrofe die ervoor zorgt dat alle dwergen sterven, zou er een natuurlijk stoppunt moeten zijn, wat het een goede benchmark-kandidaat maakt. Tenminste, dat is mijn begrip ervan (de motto van spelers is "Verliezen is leuk").

Een goede prestatie in dit spel zou afhankelijk zijn van de nauwkeurigheid van het aanroepen van tools en de aanhoudende samenhang van lange taken, plus het vermogen om de dynamiek van een complex systeem te monitoren en te begrijpen en tijdig in te grijpen om problemen te anticiperen en tegen te gaan.

En omdat het terminal native is, kan het efficiënt worden verzonden en verwerkt met behulp van reguliere tokens zonder dat multi-modale beeldverwerking nodig is, wat het veel efficiënter zou maken dan andere spellen.

Bovendien weet je dat geen enkele AI-laboratoria hierop heeft getraind (nog niet!), dus het is niet aangetast door "benchmaxxing."

4,32K

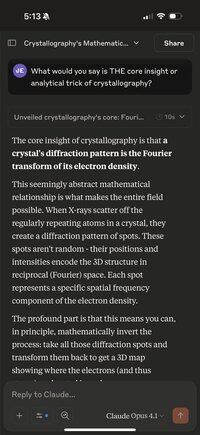

Een leuke bezigheid als je een paar minuten moet wachten, is om je telefoon te gebruiken om Claude Opus de volgende vraag te stellen over een willekeurige discipline of gebied:

"Wat zou je zeggen dat DE kerninzicht of analytische truc van kristallografie is?"

Vervang kristallografie door iets waar je aan kunt denken. Tot nu toe heb ik geprobeerd:

QED; het Standaardmodel; Biochemie; Kansrekening; Evolutionaire theorie; en nog veel meer.

Er is iets aan het dwingen van het model om het onmogelijke te doen, om een uitgestrekt, complex veld te condenseren tot "één vreemde truc," dat het echt op zoek gaat naar het beste diepe, verenigende principe in het veld en dit vervolgens beknopt verwoordt.

Dit is meestal iets dat voor beoefenaars voor de hand ligt, maar zeer waarschijnlijk onbekend is voor de meeste mensen met slechts een oppervlakkige interesse in het onderwerp.

Interessant is dat je ook herhaaldelijk op de knop "opnieuw proberen" kunt drukken met dezelfde prompt en soms heel verschillende, maar meestal zeer fascinerende, uitleggen kunt krijgen.

Ik heb al HEEL VEEL geleerd van dit, en het zou wel eens de hoogste "begrip per minuut" kunnen zijn die ik ben tegengekomen in zelfgestuurd leren.

Omdat het niet alleen leuke feitjes of coole weetjes zijn. Het zijn, per constructie, doordringende en verenigende ideeën die een enorme hoeveelheid theorie en waargenomen fenomenen in de wereld met elkaar verbinden.

Het is zeker veel meer high-bandwidth dan weer een andere YouTube-uitlegvideo met animaties en advertenties voor Brilliant/KiwiCo! Niet dat daar iets mis mee is.

8,22K

Het idee dat er recent zo'n "talentexodus" uit OpenAI heeft plaatsgevonden dat ze niet langer in staat zijn om een leider in de sector te zijn, is net zo misleidend en verkeerd als het idee dat GPT-5 "een grote flop was en dat het model niet zo geweldig is en zeer incrementeel."

Niet alleen is GPT-5 Pro nu het slimste model ter wereld met een zeer grote voorsprong op de meeste uitdagende taken in de echte wereld (vooral coderingstaken, die nu de meeste economische betekenis hebben), maar de nieuwe codex cli-tool van OpenAI is ongelooflijk goed uitgevoerd.

Ze zijn van een verre 3e plaats in codering cli-tools gegaan naar het hebben van wat nu arguably de beste is (let op dat ik Claude Code nog steeds leuk vind en gebruik, het is niet of/of!), met verreweg de beste prestaties, de laagste latentie, enz. omdat het in rust is geprogrammeerd.

En nu is deze cli-tool gecombineerd met het beste coderingsmodel dat de beste betrouwbaarheid bij het aanroepen van tools en de beste samenhang bij lange taken heeft, met de minste hoeveelheid hallucinatie.

En het hoeft geen betoog dat hun iOS-app ook dramatisch beter is dan alle andere AI-apps qua afwerking en functies. De Claude-app is gewoon de webapp in een Safari-sandbox! En hun webapp is ook nog steeds de beste. Dingen zoals zoeken werken gewoon beter dan in andere apps. Basis blokkeren en tackelen.

Dus ja. Sommige zeer slimme mensen zoals Ilya en John Schulman zijn naar andere bedrijven vertrokken. Maar ze hebben nog steeds een absoluut geweldig technisch team met ongelooflijk goede productmensen en geweldige engineeringvaardigheden.

Laat je afkeer van Altman je niet blind maken voor het voor de hand liggende. Wanneer ik weer iemand zie die zegt hoe slecht GPT-5 is, krimp ik ineen, omdat die persoon laat zien dat ze niet zelf kunnen denken op basis van bewijs en reden, en in de meme zijn getrokken om te denken dat een mening (en deze online te verkondigen) hen slim laat klinken.

34,19K

Als update voor mijn twee recente discussies over het gebruik van GPT-5 Pro om een proces te starten voor het ontdekken van baanbrekende theorieën die nieuwe toepassingen van geavanceerde wiskunde combineren met de AI-toepassingen, heb ik het model demo-implementaties in Python laten maken met Jax en Numpy voor elk van de 11 ideeën.

Vervolgens heb ik ze samengevoegd in een project en een mooie CLI toegevoegd om ze uit te voeren, en een reeks end-to-end tests die meetten of de code wiskundig correct is, controleert of de code de wiskundige eigenschappen heeft die we willen, en tenslotte of het iets nuttigs doet in vergelijking met de huidige standaardbenaderingen.

Ik heb de codex CLI met GPT-5 gebruikt om alles te integreren en eventuele bugs op te lossen. Ik zal linken naar de repo, die gedetailleerde documentatie voor het hele project bevat en vervolgens beschrijvingen voor elk van de 11 demo's die alle output bevatten die door het model tijdens het proces is gegenereerd.

3,99K

Wauw, ik heb eindelijk de tijd genomen om de nieuwe versie van OpenAI's codex CLI uit te proberen (hun antwoord op Claude Code).

De laatste keer dat ik codex probeerde (let op dat dit anders is dan hun gehoste code-agent die ook codex wordt genoemd, wat extreem verwarrend is; ik heb het nu over de tool die je lokaal op je machine in de terminal draait), was het geschreven als een Nodejs/Typescript-app, en het was echt niet goed:

- kon alleen toegang krijgen tot zwakkere modellen zoals o4-mini of hun variant voor codex, verwarrend genoeg ook codex genoemd (serieus?)

- veel slechtere UI/UX dan Claude Code

- veel slechter in coderen als gevolg van een slechter model, slechtere tooling, slechtere agentflow.

- het dwong je vervelend om toestemming voor alles te geven, waardoor je het de hele tijd moest babysitten, wat het veel minder nuttig maakte omdat je niet gemakkelijk een heleboel tegelijk kon draaien.

- misschien was dat echter een goede zaak, want veruit het grootste probleem was dat het super roekeloze, destructieve dingen deed; het was veel onvoorzichtiger dan CC.

Dat is uiteindelijk waarom ik onmiddellijk stopte met het gebruik ervan, omdat het besloot om een “git reset --hard HEAD” uit te voeren zonder eerst te stashen, en ik wat werk verloor. Nooit meer, dacht ik.

Nou, ik heb eindelijk de tijd genomen om de gloednieuwe rustversie uit te proberen die GPT-5 gebruikt en die je bestaande GPT Pro-abonnement kan gebruiken in plaats van een API-sleutel, en dit is zo veel beter dat het schokkend is.

Allereerst is er simpelweg geen vervanging voor snel gecompileerde code als het gaat om interactieve tools zoals deze.

Het feit dat het in rust is geschreven betekent dat er helemaal geen vertraging is met toetsenbordinvoer, en ook geen vreemde artefacten zoals je hebt in CC waar backspace niet goed werkt en invoer haperig en traag is omdat het is geschreven in een geïnterpreteerde taal die honderd keer langzamer is voor dit soort dingen.

Omgaan met constante vertraging en haperingen is niet alleen langzamer, het is mentaal en misschien zelfs emotioneel belastend en vermoeiend, althans voor mij als ik deze dingen urenlang gebruik. Het is een vreselijk gevoel om je gereedschappen te haten en te wreken, zelfs als je op hen afhankelijk bent om je werk te doen.

Ik hoop echt dat dit de lat voor al deze tools hoger legt en Anthropic en Google en anderen overtuigt om ook rust (of C++, Zig, wat dan ook) te gebruiken.

Maar de echt grote verbetering is uiteraard het model; met een slechter model dat onbetrouwbaar is bij het aanroepen van tools en dat coherentie verliest over langere taken, zou geen van de Rust-snelheid de moeite waard zijn.

Maar als je me hier volgt, dan weet je dat ik al ongeveer 15 minuten na de release onder de indruk ben van de coderingsvaardigheden en de tool-aanroepkracht van GPT-5 Thinking, hoewel ik het voornamelijk vanuit de agent-tab van Cursor gebruik.

De conclusie is dat deze nieuwe rust codex plotseling een echt formidabele concurrent voor CC is geworden, en je zou het absoluut moeten uitproberen.

Ik moet zien hoeveel gebruik ze me laten maken met mijn $200/maand GPT Pro-abonnement, maar als ik er een paar meer moet krijgen, zal het het zeker waard zijn.

Let op dat ik niet ben gestopt met het gebruik van CC. Ik vind het leuk om ze samen te gebruiken. En geloof het of niet, ik gebruik ook nog steeds Cursor.

Mensen moeten stoppen met het zoeken naar het ene enkele hulpmiddel dat alle anderen vervangt en omarmen dat verschillende tools verschillende sterke en zwakke punten hebben, en je krijgt de beste resultaten door dat intuïtief te leren van constant gebruik.

Hoe dan ook, doe jezelf een plezier en haal het nu. De gemakkelijkste manier is om dit commando uit te voeren (let op dat dit je de rustversie zal geven, ondanks hoe verwarrend het is om bun/npm hiervoor te gebruiken):

bun i -g @openai/codex

8,75K

Wauw, ik heb eindelijk de tijd genomen om de nieuwe versie van OpenAI's codex CLI uit te proberen (hun antwoord op Claude Code).

De laatste keer dat ik codex probeerde (let op dat dit anders is dan hun gehoste code-agent die ook codex wordt genoemd, wat extreem verwarrend is; ik heb het nu over de tool die je lokaal op je machine in de terminal draait), was het geschreven als een Nodejs/Typescript-app, en het was echt niet goed:

- kon alleen toegang krijgen tot zwakkere modellen zoals o4-mini of hun variant voor codex, verwarrend genoeg ook codex genoemd (serieus?)

- veel slechtere UI/UX dan Claude Code

- veel slechter in coderen als gevolg van een slechter model, slechtere tooling, slechtere agentflow.

- het dwong je vervelend om toestemming voor alles te geven, waardoor je het de hele tijd moest babysitten, wat het veel minder nuttig maakte omdat je niet gemakkelijk een aantal tegelijk kon draaien.

- misschien was dat echter een goede zaak, want veruit het grootste probleem was dat het super roekeloze, destructieve dingen deed; het was veel onvoorzichtiger dan CC. Dat is uiteindelijk waarom ik onmiddellijk stopte met het gebruik ervan, omdat het besloot om een “reset --hard HEAD” uit te voeren zonder eerst te stashen, en ik wat werk verloor. Nooit meer, dacht ik.

Nou, ik heb eindelijk de tijd genomen om de gloednieuwe rustversie uit te proberen die GPT-5 gebruikt en die je bestaande GPT Pro-abonnement kan gebruiken in plaats van een API-sleutel, en dit is zo veel beter dat het schokkend is.

Allereerst is er simpelweg geen vervanging voor snel gecompileerde code als het gaat om interactieve tools zoals deze.

Het feit dat het in rust is geschreven betekent dat er helemaal geen vertraging is met toetsenbordinvoer, en ook geen vreemde artefacten zoals je hebt in CC waar backspace niet goed werkt en invoer haperig en traag is omdat het is geschreven in een geïnterpreteerde taal die honderd keer langzamer is voor dit soort dingen.

Omgaan met constante vertraging en haperingen is niet alleen langzamer, het is mentaal en misschien zelfs emotioneel belastend en vermoeiend, althans voor mij als ik deze dingen urenlang gebruik. Het is een vreselijk gevoel om je gereedschappen te haten en te wreken, terwijl je toch van hen afhankelijk bent om je werk te doen.

Ik hoop echt dat dit de lat voor al deze tools hoger legt en Anthropic en Google en anderen overtuigt om ook rust (of C++, Zig, wat dan ook) te gebruiken.

Maar de echt grote verbetering is uiteraard het model; met een slechter model dat onbetrouwbaar is bij het aanroepen van tools en dat coherentie verliest over langere taken, zou geen van de Rust-snelheid de moeite waard zijn.

Maar als je me hier volgt, dan weet je dat ik al ongeveer 15 minuten na de release onder de indruk ben van de coderingsvaardigheden en de tool-aanroepkracht van GPT-5 Thinking, hoewel ik het voornamelijk vanuit de agent-tab van Cursor gebruik.

De conclusie is dat deze nieuwe rust codex plotseling een echt formidabele concurrent voor CC is geworden, en je zou het absoluut moeten uitproberen.

Ik moet zien hoeveel gebruik ze me laten maken met mijn $200/maand GPT Pro-abonnement, maar als ik er een paar meer moet krijgen, zal het het zeker waard zijn.

Let op dat ik niet ben gestopt met het gebruik van CC. Ik vind het leuk om ze samen te gebruiken. En geloof het of niet, ik gebruik ook nog steeds Cursor.

Mensen moeten stoppen met het zoeken naar het ene enkele hulpmiddel dat alle anderen vervangt en omarmen dat verschillende tools verschillende sterke en zwakke punten hebben, en je krijgt de beste resultaten door dat intuïtief te leren van constant gebruik.

Hoe dan ook, doe jezelf een plezier en haal het nu. De gemakkelijkste manier is om dit commando uit te voeren (let op dat dit je de rustversie zal geven, ondanks hoe verwarrend het is om bun/npm hiervoor te gebruiken):

bun i -g @openai/codex

874

Ik ben er absoluut van overtuigd dat de slimste AI-modellen die nu beschikbaar zijn, GPT-5 Pro en Grok4 Heavy, al slim genoeg zijn en zeker genoeg kennis hebben over wiskunde en AI, om belangrijke theoretische en praktische ontdekkingen te bedenken en te ontwikkelen, mits ze de juiste slimme aansturing krijgen.

48,15K

Boven

Positie

Favorieten

Populair op onchain

Populair op X

Recente topfinanciering

Belangrijkste