Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

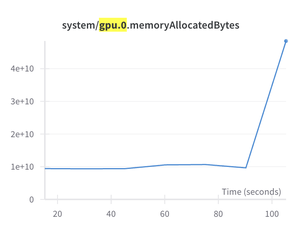

ok, ho bisogno di aiuto! Ho provato a fare il finetuning di GPT-OSS durante il fine settimana. Funziona per circa 100 passi, poi genera un errore di memoria CUDA esaurita.

La mia ipotesi è che di tanto in tanto, tutti i token vengano indirizzati a un singolo esperto. Poi l'addestramento si interrompe.

C'è una soluzione semplice? Non ho mai fatto finetuning di un MoE prima.

😒

17,19K

Principali

Ranking

Preferiti