Trendande ämnen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

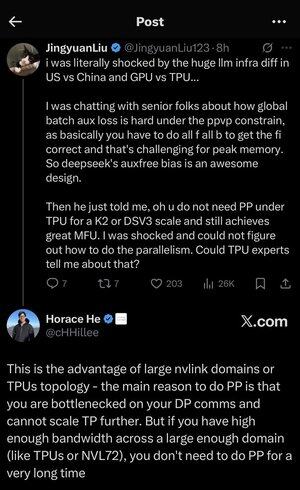

Jag gick lite vilse i alla akronymer och jargong här, så jag lät Claude förklara det utan att använda några akronymer och nu är allt helt logiskt (tldr; bandbredd ⟹ enkelhet):

Det här är en fascinerande teknisk diskussion om att träna stora språkmodeller i stor skala.

Kärnan i samtalet

Jingyuan Liu uttrycker förvåning över att ha upptäckt att man inte behöver vissa komplexa optimeringstekniker när man använder TPU:er (Tensor Processing Units - Googles specialiserade AI-chips) kontra GPU:er (Graphics Processing Units - vanligtvis NVIDIA:s chips).

Förklaring av viktiga tekniska begrepp:

Typer av hårdvara:

•GPU (Graphics Processing Unit): Ursprungligen utformad för grafik, men används nu i stor utsträckning för AI. NVIDIA dominerar denna marknad.

•TPU (Tensor Processing Unit): Googles specialdesignade chip speciellt för maskininlärning.

Strategier för parallellitet:

När du tränar massiva AI-modeller måste du dela upp arbetet på många chips. Det finns flera sätt att göra detta:

1) Dataparallellitet (DP): Varje chip bearbetar olika batcher av data med samma modellkopia

2) Tensorparallellitet (TP): Modellens matematiska operationer är uppdelade över chip

3) Pipeline Parallelism (PP): Olika lager av modellen placeras på olika chips, vilket skapar en pipeline

Den tekniska utmaningen som diskuteras:

Problemet med hjälpförlust: När du tränar mycket stora modeller lägger du ofta till "hjälpförluster" (ytterligare träningsmål) i mellanliggande lager för att hjälpa gradienter att flöda bättre genom nätverket. Under PPVP-begränsningar (Pipeline Parallelism with Variable Partitioning) blir detta komplext eftersom:

...

Topp

Rankning

Favoriter