Temas en tendencia

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

François Chollet

Cofundador @ndea. Cofundador @arcprize. Creador de Keras y ARC-AGI. Autor de 'Deep Learning with Python'.

Pudimos reproducir los sólidos hallazgos del artículo de HRM sobre ARC-AGI-1.

Además, realizamos una serie de experimentos de ablación para llegar al fondo de lo que hay detrás.

Hallazgos clave:

1. La arquitectura del modelo HRM en sí misma (la pieza central del documento) no es un factor importante.

2. El ciclo de refinamiento externo (apenas mencionado en el documento) es el principal impulsor del rendimiento.

3. El aprendizaje por transferencia entre tareas no es muy útil. Lo que importa es la capacitación en las tareas en las que se evaluará.

4. Puede usar muchos menos aumentos de datos, especialmente en el momento de la inferencia.

Los hallazgos 2 y 3 significan que este enfoque es un caso de *entrenamiento en tiempo de prueba previo cero*, similar al artículo recientemente publicado "ARC-AGI sin preentrenamiento" de Liao et al.

241.68K

Preguntas abiertas sobre la economía del transporte sin conductor:

1. ¿Cuál será la reducción de costos (sobre Uber / Lyft) de eliminar al conductor?

2. ¿Cuánto aumenta la demanda esa reducción de costos?

3. ¿El cambio de UX afectaría significativamente la demanda?

4. ¿Veríamos un gran aumento en la disponibilidad geográfica (no hay necesidad de conductores = se pueden poner más taxis en la carretera)?

Para 1: el costo laboral de un viaje de Lyft / Uber después de tener en cuenta todo lo demás es solo del 20-40% del precio, lo que limita la reducción al -40% en el mejor de los casos. Sin embargo, una red de taxis sin conductor tendría costos fijos significativamente más altos (ingenieros de IA, centros de datos) y costos unitarios adicionales distintos de cero (limpieza interior frecuente, amortización de hardware de conducción autónoma), por lo que, de manera realista, estamos viendo más como -15-20%.

Por lo tanto, es indudable que los viajes autónomos, a escala, serán más baratos que los servicios de transporte actuales. Pero el tamaño del efecto será mucho menor de lo que la mayoría de la gente espera. Seguirán siendo bastante caros.

Para 2: probablemente no tanto, debido a los precios dinámicos, los precios ya fluctúan más que esto, y hace unos años Uber estaba subsidiando fuertemente la demanda, por lo que tenemos algunos datos sobre lo que sucedería con viajes un 20% más baratos. El TAM en áreas ya bien atendidas por Uber / Lyft podría crecer ~ 20% en términos de millas, mientras se mantiene constante en términos de dólares.

Para 3: ya sabemos (a través de las implementaciones de Waymo) que las personas prefieren no tener un conductor en el automóvil, y los clientes insensibles al precio están dispuestos a pagar más por esa experiencia. Sin embargo, no todo es positivo: ha habido preocupaciones sobre la limpieza del automóvil (fácilmente abordable, pero eso aumenta los costos unitarios). En general, no creo que el cambio de UX aumente mucho el TAM, ya que para la mayoría de las personas el precio y la disponibilidad serán los factores críticos.

Para 4: este es más un comodín. La mayoría de los costos de una red autónoma son costos fijos; Los costos unitarios incrementales son principalmente la amortización del costo del automóvil (un error de redondeo) y la limpieza. Esto significa que una red autónoma tiene el potencial de tener una cobertura mucho mayor que la red actual de Uber / Lyft. Pero ciertamente no será el caso de que estas redes se extiendan *en cualquier lugar*, al menos no con un corto tiempo de espera. Creo que veremos un aumento de TAM a partir de este efecto, tal vez +20-30%.

En general: deberíamos esperar un aumento incremental de TAM en términos de dólares, pero en general el mercado se parecerá más a Uber ++ que a un nuevo paradigma de transporte. La mayoría de las personas en los EE. UU., especialmente fuera de las áreas densas, seguirán conduciendo su propio automóvil.

36.57K

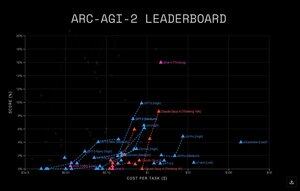

Grok 4 sigue siendo lo último en tecnología en ARC-AGI-2 entre los modelos de vanguardia.

15.9% para Grok 4 frente a 9.9% para GPT-5.

ARC Prize8 ago, 01:29

GPT-5 en la Evaluación Semi Privada de ARC-AGI

GPT-5

* ARC-AGI-1: 65.7%, $0.51/tarea

* ARC-AGI-2: 9.9%, $0.73/tarea

GPT-5 Mini

* ARC-AGI-1: 54.3%, $0.12/tarea

* ARC-AGI-2: 4.4%, $0.20/tarea

GPT-5 Nano

* ARC-AGI-1: 16.5%, $0.03/tarea

* ARC-AGI-2: 2.5%, $0.03/tarea

652

¡Resultados de GPT-5 en ARC-AGI 1 y 2!

Resumen:

65.7% en ARC-AGI-1

9.9% en ARC-AGI-2

ARC Prize8 ago, 01:29

GPT-5 en la Evaluación Semi Privada de ARC-AGI

GPT-5

* ARC-AGI-1: 65.7%, $0.51/tarea

* ARC-AGI-2: 9.9%, $0.73/tarea

GPT-5 Mini

* ARC-AGI-1: 54.3%, $0.12/tarea

* ARC-AGI-2: 4.4%, $0.20/tarea

GPT-5 Nano

* ARC-AGI-1: 16.5%, $0.03/tarea

* ARC-AGI-2: 2.5%, $0.03/tarea

39.06K

El artículo "Modelos de Razonamiento Jerárquico" ha estado circulando últimamente, acumulando decenas de miles de "me gusta" en Twitter a través de docenas de hilos semi-virales, lo cual es bastante inusual para un artículo de investigación.

El artículo afirma una precisión del 40.3% en ARC-AGI-1 con un modelo pequeño (27M de parámetros) entrenado desde cero sin ningún dato de entrenamiento externo; si es cierto, esto representaría un gran avance en el razonamiento.

Acabo de hacer un análisis profundo del artículo y la base de código...

Es una buena lectura, detallada pero fácil de seguir. Creo que las ideas presentadas son bastante interesantes y la arquitectura probablemente sea valiosa.

El concepto me recuerda a muchas ideas diferentes que encontré durante la "edad dorada" de la investigación en arquitectura de DL, alrededor de 2016-2018. Este tipo de investigación no ha sido popular durante un tiempo, así que es agradable ver un renovado interés en arquitecturas alternativas.

Sin embargo, el diseño experimental parece estar críticamente defectuoso, lo que significa que actualmente no tenemos ninguna señal empírica (al menos de ARC-AGI) sobre si la arquitectura es realmente útil o no.

El experimento ARC-AGI-1 está haciendo lo siguiente, basado en mi lectura del código de preparación de datos:

1. Entrenar en 876,404 tareas, que son variantes generadas por aumento de 960 tareas originales:

... 400 de ARC-AGI-1/train

... 400 de ARC-AGI-1/eval

... 160 de ConceptARC

2. Probar en 400 tareas (ARC-AGI-1/eval), aumentando cada tarea en ~1000 variantes (en realidad son solo 368,151 en total debido a idiosincrasias del proceso de aumento), produciendo una predicción para cada variante y reduciendo las predicciones a N=2 mediante votación mayoritaria.

En resumen: están entrenando con los datos de prueba.

Podrías preguntar, espera, ¿por qué la precisión es del 40% entonces, en lugar del 100%? ¿el modelo está severamente subajustado?

Eso es porque los datos de entrenamiento y los datos de prueba representan las mismas tareas originales *en diferentes variaciones*. El aumento de datos se aplica de manera independiente a las tareas de evaluación en los datos de entrenamiento y a las tareas de evaluación en los datos de prueba.

Así que lo que el experimento está midiendo, aproximadamente, es cómo el modelo logra generalizar a variantes generadas proceduralmente de las mismas tareas (es decir, si el modelo puede aprender a revertir un conjunto fijo de transformaciones de cuadrícula estáticas).

Así que -- no te emociones demasiado todavía. Pero creo que este tipo de investigación en arquitectura es valiosa (cuando va acompañada de una señal de validación empírica adecuada) y que la idea de HRM es muy interesante.

Además, para ser claros, no creo que los autores tuvieran la intención de engañar y ocultar el problema experimental; probablemente no se dieron cuenta de lo que realmente significaba su configuración de entrenamiento.

19.82K

Populares

Ranking

Favoritas

Onchain en tendencia

Tendencia en X

Principales fondos recientes

Más destacadas