Tendencias del momento

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Sumérgete en @nvidia 🐰 Hopper vs ⚙️ arquitecturas de GPU Blackwell: saltos sucesivos en potencia de cálculo e interconexiones para tus cargas de trabajo de IA👇

🐰 Hopper (H100 y H200) introdujo núcleos Tensor de 4ª generación + un motor de transformador FP8, ofreciendo hasta 9× más rápido entrenamiento y 30× más rápida inferencia en comparación con A100.

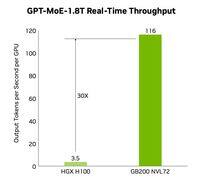

⚙️ Blackwell (B200)—enviando a finales de 2024—combina dos chips sobre un NV-HBI de 10 TB/s, añade FP4 y utiliza NVLink-5 para hasta 30× de inferencia en clúster.

@nvidia 🐰 Especificaciones de Hopper

Núcleos Tensor: mezcla de FP8/FP16/TF32

Memoria:

- H100 → 80 GB HBM3 a 3.35 TB/s

- H200 → 141 GB HBM3e a 4.8 TB/s

NVLink: hasta 900 GB/s por GPU

🐰 @nvidia Hopper en acción

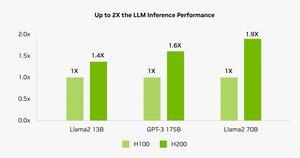

Los puntos de referencia muestran que H200 impulsa la inferencia de Llama-2 70B entre un 45 y un 100% más rápido que H100.

⚠️ Ambos experimentaron crisis de suministro en 2023-25.

💻 En la nube de Hyperbolic: VMs H100 y clusters bare-metal con Ethernet + InfiniBand a partir de $1.49/hr. H200 & B200 a través de cotización instantánea.

⚙️ @nvidia Innovaciones de Blackwell

- Diseño de chiplet (TSMC 4NP, transistores 208 B, 10 TB/s NV-HBI)

- Motor Transformer de 2.ª generación: FP4 + FP8 mejorado

- NVLink-5: 18 enlaces @ 1.8 TB/s en total

- Motor de descompresión: GPU de CPU↔de 800 GB/s

- RAS completo y computación confidencial

📊 Comparando Rendimiento

H100 SXM: 80 GB @ 3.35 TB/s, 3.96 PFLOPS (FP8), 1.98 PFLOPS (FP16), 67 TFLOPS (FP32), NVLink 900 GB/s, 700 W

H200 SXM: 141 GB @ 4.8 TB/s, mismos PFLOPS/TFLOPS de computación, NVLink 900 GB/s, 700 W

HGX B200: 180 GB @ 7.7 TB/s, 9 PFLOPS (FP8), 4.5 PFLOPS (FP16), 75 TFLOPS (FP32), NVLink 1.8 TB/s, 1000 W

❓ @nvidia ¿Qué es un FLOP?

1 operación de punto flotante (agregar / mul)

1 TFLOP = 10¹² ops/s

1 PFLOP = 10¹⁵ ops/s = 1000× un TFLOP

Estas métricas muestran cuán rápido las GPU procesan las matemáticas masivas detrás del entrenamiento de IA y HPC.

🔚 @nvidia Conclusión:

🐰 Hopper estableció el estándar con tuberías de precisión mixta y asíncronas FP8.

⚙️ Blackwell impulsa la próxima generación con FP4, más memoria, NVLink-5.

H100 sigue siendo el caballo de batalla: alquiler a través de $ 1.49 / hora.

H200 y B200 disponibles bajo pedido a través de

@nvidia Lee el artículo completo en:

4,09K

Parte superior

Clasificación

Favoritos