Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Plongez dans les architectures GPU @nvidia 🐰 Hopper vs ⚙️ Blackwell—des avancées successives en puissance de calcul et en interconnexions pour vos charges de travail en IA👇

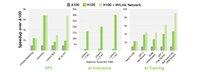

🐰 Hopper (H100 et H200) a introduit des cœurs Tensor de 4ème génération + un moteur de transformateur FP8, offrant jusqu'à 9× d'entraînement plus rapide et 30× d'inférence plus rapide par rapport à l'A100.

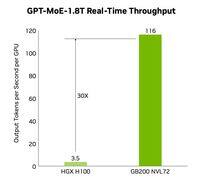

⚙️ Blackwell (B200) — expédition fin 2024 — associe deux dies sur un NV-HBI de 10 To/s, ajoute FP4 et utilise NVLink-5 pour jusqu'à 30× d'inférence en cluster.

@nvidia 🐰 Spécifications Hopper

Cœurs Tensor : mixte FP8/FP16/TF32

Mémoire :

- H100 → 80 Go HBM3 @ 3,35 To/s

- H200 → 141 Go HBM3e @ 4,8 To/s

NVLink : jusqu'à 900 Go/s par GPU

🐰 @nvidia Hopper en action

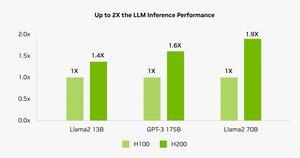

Les benchmarks montrent que H200 alimente Llama-2 70B inférence 45 à 100 % plus rapide que H100.

⚠️ Les deux ont connu des pénuries d’approvisionnement en 2023-25.

💻 Sur le cloud d’Hyperbolic : VM H100 et clusters bare metal avec Ethernet + InfiniBand à partir de 1,49 $/h. H200 et B200 via devis instantané.

⚙️ @nvidia Blackwell Innovations

- Conception de chiplet (TSMC 4NP, transistors 208 B, NV-HBI 10 TB/s)

- Moteur transformateur de 2e génération : FP4 + FP8 amélioré

- NVLink-5 : 18 liens @ 1,8 To/s au total

- Moteur de décompression : GPU CPU↔800 GB/s

- RAS complet et calcul confidentiel

📊 Comparaison des performances

H100 SXM : 80 Go @ 3,35 To/s, 3,96 PFLOPS (FP8), 1,98 PFLOPS (FP16), 67 TFLOPS (FP32), NVLink 900 Go/s, 700 W

H200 SXM : 141 Go @ 4,8 To/s, mêmes PFLOPS/TFLOPS de calcul, NVLink 900 Go/s, 700 W

HGX B200 : 180 Go @ 7,7 To/s, 9 PFLOPS (FP8), 4,5 PFLOPS (FP16), 75 TFLOPS (FP32), NVLink 1,8 To/s, 1000 W

❓ @nvidia Qu’est-ce qu’un FLOP ?

1 opération en virgule flottante (add/mul)

1 TFLOP = 10¹² ops/s

1 PFLOP = 10¹⁵ ops/s = 1000× un TFLOP

Ces mesures montrent à quelle vitesse les GPU analysent les mathématiques massives derrière l’entraînement de l’IA et le HPC.

🔚 @nvidia Conclusion :

🐰 Hopper a placé la barre très haut avec des pipelines FP8 de précision mixte et asynchrones.

⚙️ Blackwell pousse la nouvelle génération avec FP4, plus de mémoire, NVLink-5.

H100 reste le cheval de bataille – loyer de 1,49 $/heure.

H200 et B200 disponibles sur demande via

@nvidia Lisez l'article complet à :

4,07K

Meilleurs

Classement

Favoris