Trendaavat aiheet

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Teknologiajätit käyttävät Multimodal RAG:ia joka päivä tuotannossa!

- Spotify käyttää sitä musiikkikyselyihin vastaamiseen

- YouTube käyttää sitä kehotteiden muuttamiseen raidoiksi

- Amazon Music käyttää sitä soittolistan luomiseen kehotteesta

Opetellaan rakentamaan multimodaalinen agenttinen aluetukialue (koodilla):

Tänään rakennamme multimodaalisen Agentic RAG:n, joka voi kysellä asiakirjoja ja äänitiedostoja käyttäjän puheen avulla.

Tekninen pino:

- @AssemblyAI transkriptiota varten.

- @milvusio vektorina DB.

- @beam_cloud käyttöönottoon.

- @crewAIInc Työnkulut orkestrointia varten.

Rakennetaan se!

Tässä on työnkulku:

- Käyttäjä syöttää tietoja (ääni + asiakirjat).

- AssemblyAI litteroi äänitiedostot.

- Transkriboitu teksti ja dokumentit upotetaan Milvus-vektoritietokantaan.

- Tutkimusagentti hakee tietoja käyttäjän kyselystä.

- Vastausagentti käyttää sitä vastauksen laatimiseen.

Tarkista tämä👇

1️⃣ Tietojen käsittely

Aluksi käyttäjä antaa teksti- ja äänisyötetiedot datahakemistoon.

CrewAI Flow toteuttaa logiikan tiedostojen löytämiseksi ja niiden valmistelemiseksi jatkokäsittelyä varten.

Tarkista tämä👇

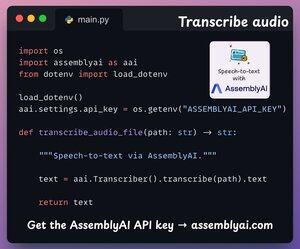

2️⃣ Litteroi ääni

Seuraavaksi litteroimme käyttäjän äänisyötteen AssemblyAI:n Speech-to-text-alustalla.

AssemblyAI ei ole avoimen lähdekoodin, mutta se antaa runsaasti ilmaisia krediittejä SOTA-transkriptiomalliensa käyttämiseen, jotka ovat enemmän kuin riittäviä tähän demoon.

Tarkista tämä👇

3️⃣ Upota syöttötiedot

Jatkossa yllä olevan vaiheen litteroitu syöttödata ja syötetty tekstidata upotetaan ja tallennetaan Milvus-vektoritietokantaan.

Näin teemme sen 👇

4️⃣ Käyttäjän kysely

Nieleminen on ohi.

Nyt siirrytään päättelyvaiheeseen!

Seuraavaksi käyttäjä syöttää äänikyselyn, jonka AssemblyAI litteroi.

Tarkista tämä👇

5️⃣ Hae konteksti

Seuraavaksi luodaan kyselylle upotus ja haetaan olennaisimmat palat Milvus-vektoritietokannasta.

Näin me teemme sen 👇

6️⃣ Luo vastaus

Kun meillä on asiaankuuluva konteksti, miehistöämme kutsutaan luomaan selkeä ja lainattu vastaus käyttäjälle.

Tarkista tämä 👇

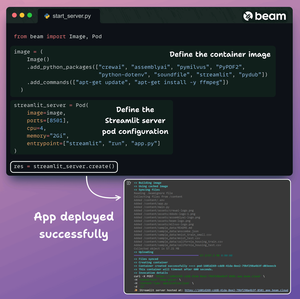

Lopuksi käärimme kaiken puhtaaseen Streamlit-käyttöliittymään ja otamme sovelluksen käyttöön palvelimettomaan säilöön Beamin avulla.

Tuomme tarvittavat Python-riippuvuudet ja määritämme säilön laskentamääritykset.

Ja sitten otamme sovelluksen käyttöön muutamalla koodirivillä👇

Kun se on otettu käyttöön, saamme 100-prosenttisesti yksityisen käyttöönoton juuri rakentamallemme Multimodal RAG Agentic -työnkululle.

Katso tämä demo 👇

Tässä on toteuttamamme työnkulku:

- Käyttäjän antamat tiedot (ääni + dokumentit)

- AssemblyAI litteroi äänitiedostot

- Litteroitu data upotetaan vektoritietokantaan

- Tutkimusagentti haki tietoja käyttäjän kyselystä

- Vastausagentti käytti sitä vastauksen laatimiseen

Tarkista tämä👇

Jos se oli mielestäsi oivaltava, jaa se uudelleen verkostosi kanssa.

Etsi minut → @akshay_pachaar ✔️

Lisää näkemyksiä ja opetusohjelmia LLM:istä, tekoälyagenteista ja koneoppimisesta!

5.8.2025

Teknologiajätit käyttävät Multimodal RAG:ia joka päivä tuotannossa!

- Spotify käyttää sitä musiikkikyselyihin vastaamiseen

- YouTube käyttää sitä kehotteiden muuttamiseen raidoiksi

- Amazon Music käyttää sitä soittolistan luomiseen kehotteesta

Opetellaan rakentamaan multimodaalinen agenttinen aluetukialue (koodilla):

422

Johtavat

Rankkaus

Suosikit