Topik trending

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

steve hsu

Fisikawan, Pendiri AI, Podcast Manifold

Intuisi saya adalah bahwa sesuatu seperti ini (di luar arsitektur transformator sederhana) diperlukan untuk mencapai AGI/ASI yang nyata.

Kabar baiknya adalah bahwa lapisan tambahan ini mungkin relatif mudah dibangun. Sebagian kecil dari sumber daya (baik komputasi maupun sumber daya manusia) yang dikhususkan untuk hyperscaling mungkin membawa kita ke sana.

Saya melihat banyak ide-ide inovatif seperti ini datang dari Sinosphere. JIKA hyperscaling bukanlah jalan menuju AGI/ASI (berlawanan dengan ide-ide baru yang cerdas dan arsitektur yang lebih baik) maka keunggulan AS atas China mungkin nol atau bahkan negatif!

DailyPapers8 Agu, 12.22

Tencent AI Lab memperkenalkan R-Zero!

Kerangka kerja inovatif yang memungkinkan LLM untuk mengembangkan kemampuan penalaran mereka sendiri

dari nol data yang dikuratori manusia, melalui loop Challenger-Solver otonom.

16,67K

Musk: Steve, pertanyaan sebenarnya yang terus saya tanyakan kepada tim adalah apakah LLM saat ini dapat beralasan ketika mereka meninggalkan distribusi pelatihan. Semua orang mengutip petunjuk rantai pemikiran, tetapi itu bisa jadi hanya mimikri.

Hsu: Setuju. Tolok ukur terbaru menunjukkan bahwa bahkan model tingkat Grok4 menurun tajam setelah Anda memaksakan pergeseran domain — ruang laten tidak mencakup modalitas baru.

Musk: Jadi ini lebih merupakan masalah cakupan daripada kegagalan penalaran?

Hsu: Sebagian. Tapi ada masalah yang lebih dalam. Satu-satunya bias induktif bawaan transformator adalah pencocokan pola asosiatif. Ketika prompt benar-benar di luar distribusi—katakanlah, teka-teki simbolis yang tokennya tidak pernah terjadi bersamaan dalam pelatihan—model tidak memiliki struktural sebelum kembali ke sana. Itu benar-benar melempar koin.

Musk: Namun kami melihat "grokking" yang muncul pada tugas-tugas sintetis. Zhong et al. menunjukkan bahwa kepala induksi dapat menyusun aturan yang tidak pernah mereka latih secara eksplisit. Bukankah itu terlihat seperti penalaran?

Hsu: Komposisi memberi Anda generalisasi terbatas, tetapi aturannya masih harus terletak pada rentang tata bahasa pelatihan. Segera setelah Anda mengubah semantik—mengubah satu operator dalam teka-teki—akurasinya runtuh. Itu bukan alasan yang kuat; itu interpolasi rapuh.

Musk: Tidak bisakah pembelajaran penguatan memperbaikinya? DRG-Sapphire menggunakan GRPO di atas model dasar 7 B dan mendapatkan pengkodean kelas dokter pada catatan klinis, tugas OOD klasik.

Hsu: Tangkapannya adalah bahwa RL hanya berfungsi setelah model dasar telah menyerap pengetahuan domain yang cukup melalui penyetelan halus yang diawasi. Ketika korpus pra-pelatihan jarang, RL saja mendatar. Jadi "penalaran" masih parasit pada kepadatan pengetahuan sebelumnya.

Musk: Jadi kesimpulan Anda adalah bahwa penskalaan data dan parameter tidak akan menyelesaikan masalah? Kita akan selalu menabrak dinding di mana domain OOD berikutnya merusak model?

Hsu: Belum tentu dinding, tapi langit-langit. Kurva empiris menunjukkan bahwa kesalahan generalisasi meluruh secara kasar secara logaritmik dengan contoh pelatihan. Itu menyiratkan Anda membutuhkan lebih banyak data secara eksponensial untuk setiap distribusi ekor baru. Untuk vertikal sempit—katakanlah, diagnostik mesin roket—lebih murah untuk memanggang di awal simbolis daripada menskalakan secara membabi buta.

Musk: Yang membawa kita kembali ke hibrida neuro-simbolik. Berikan LLM akses ke pemecah kecil terverifikasi, lalu biarkan mengatur panggilan saat distribusi bergeser.

Hsu: Tepat. LLM menjadi meta-pengontrol yang mengenali kapan OOD dan diserahkan ke modul khusus. Arsitektur itu menghindari kekeliruan "satu transformator raksasa".

Musk: Baiklah, saya akan memberi tahu tim xAI untuk berhenti mengejar triliunan token berikutnya dan mulai membangun lapisan perutean. Terima kasih, Steve.

Hsu: Kapan saja. Dan jika Anda membutuhkan kasus uji OOD sintetis, lab saya memiliki generator yang sudah tertipu GPT-5. Saya akan mengirim repo.

Percakapan dengan Elon ini mungkin dihasilkan AI.

67,74K

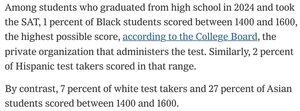

NYT dipaksa untuk mencetak fakta yang BENAR-BENAR tidak disukai.

SPUTNIK MOMENT = waktu untuk berkompetisi, tidak ada lagi COPE

"Setelah Perang Dunia II, ketika Amerika Serikat menghadapi peningkatan persaingan militer dan ilmiah dari Uni Soviet, universitas-universitas selektif mulai memberikan bobot yang lebih besar pada faktor-faktor akademik, termasuk SAT," kata Nicholas Lemann, yang telah menulis tentang sejarah pengujian standar dan merupakan profesor jurnalisme di Universitas Columbia.

28,18K

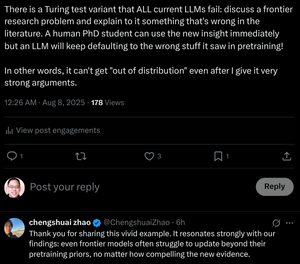

"Bahkan model perbatasan berjuang untuk memperbarui melampaui prapelatihan sebelumnya, tidak peduli seberapa kuat bukti barunya."

Kami melatih mahasiswa PhD untuk melakukan ini! Bisakah transformator melakukannya tanpa mengubah bobotnya?

steve hsu8 Agu, 07.29

Apakah penalaran rantai pemikiran LLM adalah fatamorgana?

... Hasil kami mengungkapkan bahwa penalaran CoT adalah fatamorgana rapuh yang menghilang ketika didorong melampaui distribusi pelatihan. Karya ini menawarkan pemahaman yang lebih dalam tentang mengapa dan kapan penalaran CoT gagal, menekankan tantangan berkelanjutan untuk mencapai penalaran yang asli dan dapat digeneralisasi.

... Temuan kami mengungkapkan bahwa penalaran CoT bekerja secara efektif ketika diterapkan pada distribusi dalam atau dekat

data dalam distribusi tetapi menjadi rapuh dan rentan terhadap kegagalan bahkan di bawah pergeseran distribusi sedang.

Dalam beberapa kasus, LLM menghasilkan langkah-langkah penalaran yang lancar namun tidak konsisten secara logis. Hasilnya menunjukkan bahwa apa yang tampak sebagai penalaran terstruktur dapat menjadi fatamorgana, muncul dari pola yang dihafal atau diinterpolasi dalam data pelatihan daripada kesimpulan logis.

... Bersama-sama, temuan ini menunjukkan bahwa LLM bukanlah penalaran yang berprinsip melainkan simulator teks seperti penalaran yang canggih.

13,76K

Presiden Trump diperkirakan akan menandatangani memorandum pada hari Kamis yang mengharuskan perguruan tinggi untuk menyerahkan data penerimaan kepada pemerintah federal untuk memverifikasi kepatuhan terhadap keputusan Mahkamah Agung 2023 yang mengakhiri kebijakan sadar ras, menurut seorang pejabat senior Gedung Putih.

Tindakan presiden juga mengharuskan Linda McMahon, sekretaris pendidikan, untuk meningkatkan jumlah pemeriksaan akurasi pada data yang disediakan oleh sekolah dan untuk mengambil tindakan terhadap universitas yang mengirimkan informasi yang tidak tepat waktu atau tidak akurat.

Memorandum tersebut juga akan mengharuskan Departemen Pendidikan untuk mengubah prosesnya untuk mengumpulkan data pendidikan tinggi, yang dikenal sebagai Sistem Data Pendidikan Pasca Sekolah Menengah Terpadu, yang mencakup rincian tentang penerimaan, pendaftaran, dan bantuan keuangan. Informasi itu akan dibuat lebih mudah diakses oleh publik, menurut lembar fakta.

steve hsu6 Agu, 07.05

NYTimes: Columbia dan Brown akan Mengungkapkan Data Penerimaan dan Ras dalam Kesepakatan Trump

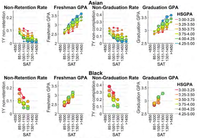

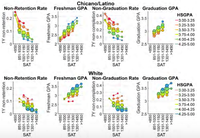

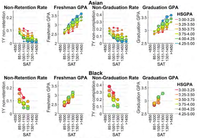

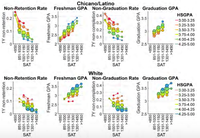

Dibutuhkan ancaman eksistensial dari Trump untuk membuat mereka merilis data ini. Bertahun-tahun yang lalu sebuah komite fakultas dari sistem University of California memeriksa data semacam ini dan menghasilkan grafik di bawah ini. Jika Anda melihat data, Anda akan memahami sifat mengerikan dari tindakan afirmatif seperti yang dipraktikkan di AS selama ~50 tahun.

NYT: ... Columbia dan Brown harus mempertahankan "kebijakan penerimaan berbasis prestasi," menurut penyelesaian mereka, yang mengkodifikasi tujuan administrasi yang lebih luas dalam bahasa yang mengikat secara hukum.

Universitas "tidak boleh secara tidak sah memilih pelamar berdasarkan ras, warna kulit atau asal negara dalam penerimaan di seluruh programnya," kedua perjanjian menyatakan dalam bahasa yang sama. "Tidak ada proksi untuk penerimaan rasial yang akan ditoleransi."

... "Departemen Kehakiman akan mengakhiri sistem yang memalukan di mana ras seseorang lebih penting daripada kemampuan mereka," kata Chad Mizelle, penjabat jaksa agung, pada bulan Maret. "Setiap perguruan tinggi dan universitas harus tahu bahwa diskriminasi ilegal dalam penerimaan akan diselidiki dan dihilangkan."

Bahasa yang digunakan dalam penyelesaian dengan Columbia dan Brown membantah pernyataan tentang kasus penerimaan Mahkamah Agung yang telah dibuat pemerintahan Trump sejak Februari.

Ia bersikeras bahwa keputusan itu melampaui penerimaan dan melarang pertimbangan ras dalam kehidupan universitas.

7,49K

NYTimes: Columbia dan Brown akan Mengungkapkan Data Penerimaan dan Ras dalam Kesepakatan Trump

Dibutuhkan ancaman eksistensial dari Trump untuk membuat mereka merilis data ini. Bertahun-tahun yang lalu sebuah komite fakultas dari sistem University of California memeriksa data semacam ini dan menghasilkan grafik di bawah ini. Jika Anda melihat data, Anda akan memahami sifat mengerikan dari tindakan afirmatif seperti yang dipraktikkan di AS selama ~50 tahun.

NYT: ... Columbia dan Brown harus mempertahankan "kebijakan penerimaan berbasis prestasi," menurut penyelesaian mereka, yang mengkodifikasi tujuan administrasi yang lebih luas dalam bahasa yang mengikat secara hukum.

Universitas "tidak boleh secara tidak sah memilih pelamar berdasarkan ras, warna kulit atau asal negara dalam penerimaan di seluruh programnya," kedua perjanjian menyatakan dalam bahasa yang sama. "Tidak ada proksi untuk penerimaan rasial yang akan ditoleransi."

... "Departemen Kehakiman akan mengakhiri sistem yang memalukan di mana ras seseorang lebih penting daripada kemampuan mereka," kata Chad Mizelle, penjabat jaksa agung, pada bulan Maret. "Setiap perguruan tinggi dan universitas harus tahu bahwa diskriminasi ilegal dalam penerimaan akan diselidiki dan dihilangkan."

Bahasa yang digunakan dalam penyelesaian dengan Columbia dan Brown membantah pernyataan tentang kasus penerimaan Mahkamah Agung yang telah dibuat pemerintahan Trump sejak Februari.

Ia bersikeras bahwa keputusan itu melampaui penerimaan dan melarang pertimbangan ras dalam kehidupan universitas.

24,74K

Grafik lain 💀 - misalnya lihat derivatif pertama yang rata-rata selama ~12 bulan 🤔 terakhir

🐒 < -- Pria yang berbicara besar tentang kebijakan AI tetapi berjuang dengan komputasi derivatif pertama. Amerika Serikat! Amerika Serikat! TIDAK APA-APA!

steve hsu5 Agu, 18.32

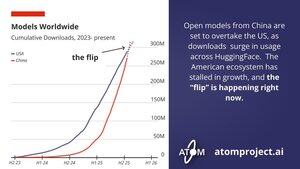

Dukung ATOM! AI sumber terbuka bagus!

Di bawah ini, grafik lain 💀. Hal-hal JAUH lebih buruk daripada yang ditunjukkan grafik ini karena sebagian besar unduhan model China mungkin tidak terjadi di HuggingFace. Dengan ~50% pengembang AI di RRT, dan ~100% unduhan mereka adalah model terbuka yang dibuat oleh laboratorium Tiongkok (Llama tidak kompetitif, sejujurnya), titik persimpangan telah terjadi di tingkat global.

36,44K

Dukung ATOM! AI sumber terbuka bagus!

Di bawah ini, grafik lain 💀. Hal-hal JAUH lebih buruk daripada yang ditunjukkan grafik ini karena sebagian besar unduhan model China mungkin tidak terjadi di HuggingFace. Dengan ~50% pengembang AI di RRT, dan ~100% unduhan mereka adalah model terbuka yang dibuat oleh laboratorium Tiongkok (Llama tidak kompetitif, sejujurnya), titik persimpangan telah terjadi di tingkat global.

Nathan Lambert4 Agu, 22.08

Amerika perlu menanggapi model terbuka dengan lebih serius. Musim panas ini, keunggulan awal dalam adopsi model terbuka AS melalui Llama telah diambil alih oleh model Cina.

Dengan Proyek American Truly Open Models (ATOM), kami ingin membangun dukungan dan mengekspresikan urgensi masalah ini.

44,31K

Teratas

Peringkat

Favorit

Trending onchain

Trending di X

Pendanaan teratas terbaru

Paling terkenal