Trendande ämnen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Om du läser en sak den här veckan, skulle du föreslå följande AI-rapport:

"Från datagjuterier till världsmodeller"

Den väver samman datagjuterier, kontextteknik, RL-miljöer, världsmodeller och mer till en lättillgänglig, men ändå omfattande uppsats om den nuvarande kanten av AI. 👇

Hela artikeln:

🧵under:

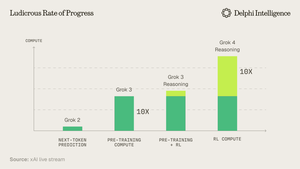

1) Från Grok 4-utgåvan är det tydligt att vi inte har träffat "en vägg" i beräkningsutgifter.

Källa: @xai

2) Data verkar i allt högre grad vara den korta stången i tältet.

Källa: @EpochAIResearch

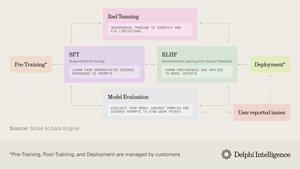

3) Det mesta av dessa utgifter går till att generera datauppsättningar av hög kvalitet för efterträning, vilket snabbt närmar sig 50 % av beräkningsbudgetarna

4) Detta har lett till en ökad efterfrågan på "datagjuterier" som @scale_AI @HelloSurgeAI @mercor_ai med flera, som hjälper till att hitta den nödvändiga expertisen och skapar datapipelines som är nödvändiga för RL i icke-verifierbara domäner.

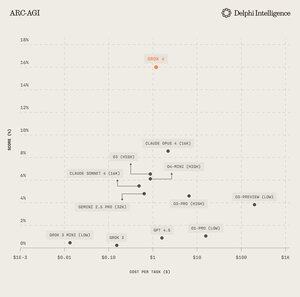

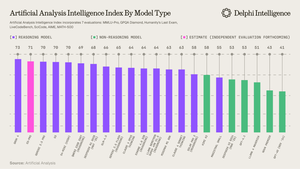

5) Vilket kan bidra till att ge bränsle åt allt mer kapabla resonemangsmodeller, helt klart skalningsparadigmet du jour per @ArtificialAnlys

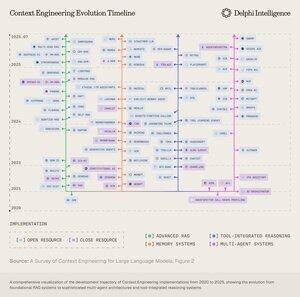

6) Och ändå är modeller inte längre begränsade av IQ utan av kontext. Prompt engineering har lämnat över stafettpinnen till "Context Engineering" - ett växande område som optimerar informationsnyttolaster till LLM:er.

7) Utrymmet är extremt dynamiskt men innebär i allmänhet skalning av kontext över 2 vektorer:

1. Kontextlängd: de beräkningsmässiga och arkitektoniska utmaningarna med att bearbeta ultralånga sekvenser

2. Multimodal: skala kontext bortom text till verkligt multimodala miljöer.

8) Det kanske ultimata uttrycket för kontext är att skapa "RL-miljöer" som perfekt efterliknar uppgifter som RL kan köras på.

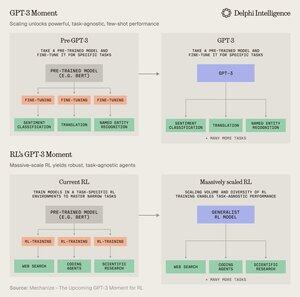

Även om data är begränsade idag, tror @MechanizeWork att vi är på väg mot en "GPT-3-liknande" böjning med massivt skalad RL

9) Att skapa dessa miljöer är dock ganska arbetsintensivt och verkar inte särskilt "bitter-lektionspiller".

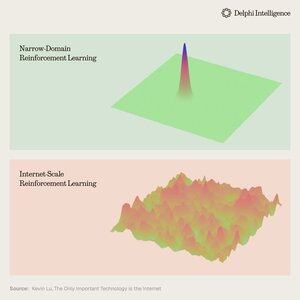

@_kevinlu undrar om det finns ett sätt att utnyttja internet för efterträning som gjordes för förträning?

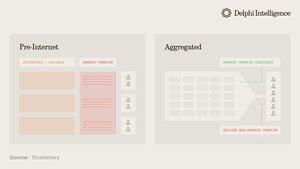

10) Även om det är en intressant tanke, har mycket av internet fångats av ett fåtal stora ekosystem som är vertikalt integrerade och snabbt genomför RL över sina ingredienser för ännu snabbare RL

(d.v.s. alfa utvecklas från @GoogleDeepMind )

11) Det är oklart om dessa stora företag ser olika RL-miljöer som nödvändiga eller bara ett tillfälligt stopp på väg till fullständiga "världsmodeller", komplett med digitala tvillingar av nästan alla fenomen

Genie 3 från Google är verkligen en nick i denna riktning:

5 aug. 2025

What if you could not only watch a generated video, but explore it too? 🌐

Genie 3 is our groundbreaking world model that creates interactive, playable environments from a single text prompt.

From photorealistic landscapes to fantasy realms, the possibilities are endless. 🧵

12) Vilket väcker frågan: är vertikalt integrerade metoder för att bygga syntetisk intelligens med snabbare RL-återkopplingsslingor avsedda att rusa framåt och fånga marknaden eller kan modulära system av latent beräkning, data och talang konkurrera med effektiv orkestrering?

843

Topp

Rankning

Favoriter