Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Tomasz Tunguz

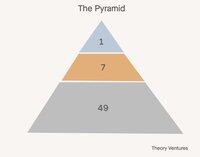

Heute bauen wir Teams in Pyramiden auf. Ein Leiter, mehrere Manager, viele individuelle Mitarbeiter.

In der Welt der KI, welche Teamkonfiguration macht am meisten Sinn? Hier sind einige Alternativen:

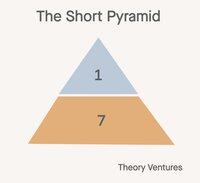

Zuerst die kurze Pyramide. Manager werden zu Agent-Managern. Die Arbeit, die früher von individuellen Mitarbeitern geleistet wurde, wird zur Arbeitslast der Agenten. Jeder bewegt sich auf eine Ebene der Abstraktion in der Arbeit nach oben.

Diese Konfiguration reduziert die Mitarbeiterzahl um 85% (1:7:49 -> 1:7). Das Verhältnis von Managern zu individuellen Mitarbeitern geht von 1:7 auf 1:1. Das Verhältnis von Managern zu Agenten bleibt 1:7.

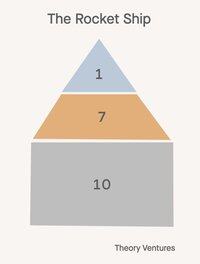

Zweitens, das Raketen-Schiff 🚀!

Ein Direktor, sieben Manager, 21 Mitarbeiter. Jeder in der Organisation verwaltet Agenten, aber diese Agenten spiegeln ihre Seniorität wider. Der Direktor verwaltet einen KI-Chef, die Manager sind Spieler-Coaches, die sowohl selbst Ziele erreichen als auch andere darin schulen/coachen, wie man KI erfolgreich manipuliert, was die Kontrollspanne halbiert.

Diese Konfiguration reduziert die Mitarbeiterzahl (1:7:49 -> 1:7:14) um 53%.

Die Zukunft ist nicht für alle gleich.

Hier ist die Wendung: Nicht jede Abteilung in einem Unternehmen wird die gleiche Organisationsstruktur übernehmen. Die Auswirkungen von KI variieren dramatisch je nach Funktion und schaffen eine Welt, in der die Form eines Unternehmens nuancierter wird als je zuvor.

Vertriebsteams werden wahrscheinlich traditionelle Pyramiden oder Raketen-Schiffe beibehalten. Beziehungen treiben den Umsatz an, und menschliche Empathie, Kreativität und Verhandlungsgeschick bleiben unersetzlich. Die klassischen Modelle der Kontrollspanne gelten weiterhin, wenn Vertrauen und Rapport von größter Bedeutung sind.

F&E-Teams bieten die größte Chance für die Transformation zur kurzen Pyramide. Die Code-Generierung ist das erste echte Produkt-Markt-Übereinstimmung von KI und generiert 50-80% des Codes für führende Unternehmen.

Der Kundenservice und Support könnten sich in hybride Modelle entwickeln: KI bearbeitet routinemäßige Anfragen, während Menschen komplexe Eskalationen und strategische Konten verwalten. Die traditionelle mittlere Managementebene verwandelt sich in etwas völlig Neues.

Diese Evolution stellt alles in Frage, was wir über die effektive Skalierung von Teams wissen. Die alte Weisheit von 6-7 direkten Berichten bricht zusammen, wenn Manager sowohl menschliche Berichte als auch KI-Agenten überwachen.

Die Rekrutierungsbelastung, die historisch die Managementhierarchien rechtfertigte, verändert sich ebenfalls. Anstatt menschliches Talent zu finden und zu entwickeln, konzentrieren sich Manager zunehmend darauf, KI-Fähigkeiten zu konfigurieren und die Zusammenarbeit zwischen Mensch und KI zu optimieren.

Wenn das Unternehmen sein Organigramm ändert, welches Organigramm stellen Sie sich für Ihr Team vor?

577

Eine Billion Token pro Tag. Ist das viel?

„Und wenn wir uns nur die Anzahl der Token ansehen, die von den Foundry-APIs bereitgestellt werden, haben wir in diesem Quartal über 100 Billionen Token verarbeitet, was einem Anstieg von 5x im Vergleich zum Vorjahr entspricht, einschließlich eines Rekords von 50 Billionen Token allein im letzten Monat.“

Im April teilte Microsoft eine Statistik mit, die zeigt, dass ihr Foundry-Produkt etwa 1,7 Billionen Token pro Monat verarbeitet.

Gestern teilte Vipul mit, dass täglich 2 Billionen Open-Source-Inferenz verarbeitet werden.

Im Juli kündigte Google eine erstaunliche Zahl an:

„Auf der I/O im Mai haben wir angekündigt, dass wir monatlich 480 Billionen Token über unsere Oberflächen verarbeitet haben. Seitdem haben wir diese Zahl verdoppelt und verarbeiten jetzt über 980 Billionen monatliche Token, ein bemerkenswerter Anstieg.“

Google verarbeitet täglich 32,7 Billionen, 16x mehr als Together und 574x mehr als das Volumen von Microsoft Foundry im April.

Aus diesen Zahlen können wir einige Hypothesen ableiten:

1. Open-Source-Inferenz ist ein einstelliger Bruchteil der Inferenz. Es ist unklar, welcher Anteil von Googles Inferenz-Token aus ihren Open-Source-Modellen wie Gemma stammt. Aber wenn wir annehmen, dass Anthropic und OpenAI 5-10 Billionen Token pro Tag und alle Closed-Source sind, plus Azure, das ungefähr ähnlich groß ist, dann liegt die Open-Source-Inferenz wahrscheinlich bei etwa 1-3% der gesamten Inferenz.

2. Agenten sind früh. Der Datenpunkt von Microsoft deutet darauf hin, dass die Agenten innerhalb von GitHub, Visual Studio, Copilot Studio und Microsoft Fabric weniger als 1% der gesamten KI-Inferenz auf Azure beitragen.

3. Da Microsoft in diesem Jahr voraussichtlich 80 Milliarden Dollar im Vergleich zu Googles 85 Milliarden Dollar in die KI-Datenzentrum-Infrastruktur investieren wird, sollten die KI-Inferenz-Workloads jedes Unternehmens sowohl durch die Inbetriebnahme von Hardware als auch durch algorithmische Verbesserungen erheblich zunehmen.

„Durch Softwareoptimierung allein liefern wir 90% mehr Token für dasselbe GPU im Vergleich zum Vorjahr.“

Microsoft presst mehr digitale Limonade aus ihren GPUs und Google muss ebenfalls Ähnliches tun.

Wann werden wir die ersten 10 Billionen oder 50 Billionen KI-Token pro Tag sehen? Es kann nicht mehr lange dauern.

- Schätzungen aus der Luft!

- Google und Azure bei jeweils 33 Billionen Token pro Tag, Together und 5 andere Neoclouds bei jeweils etwa 2 Billionen Token pro Tag, und Anthropic und OpenAI bei 5 Billionen Token pro Tag, ergibt uns 88 Billionen Token pro Tag. Wenn wir annehmen, dass 5% von Googles Token aus Open-Source-Modellen stammen, sind das 1,65 Billionen Token pro Tag oder ungefähr 1,9% der gesamten Inferenz. Wieder sehr grobe Mathematik.

873

Top

Ranking

Favoriten