Tópicos populares

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Tomasz Tunguz

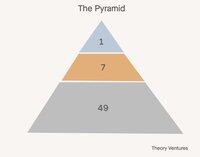

Hoje, construímos equipas em pirâmides. Um líder, vários gestores, muitos colaboradores individuais.

No mundo da IA, que configuração de equipa faz mais sentido? Aqui estão algumas alternativas:

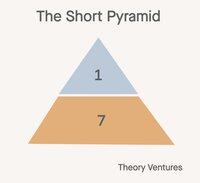

Primeiro, a pirâmide curta. Os gestores tornam-se gestores de agentes. O trabalho realizado pelos colaboradores individuais de outrora torna-se as cargas de trabalho dos agentes. Todos sobem um nível de abstração no trabalho.

Esta configuração reduz o número de funcionários em 85% (1:7:49 -> 1:7). A proporção de gestores para colaboradores individuais passa de 1:7 para 1:1. A proporção de gestores para agentes mantém-se em 1:7.

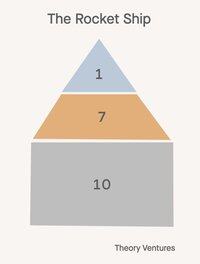

Em segundo lugar, a nave espacial 🚀!

Um diretor, sete gestores, 21 funcionários. Todos na organização estão a gerir agentes, mas estes agentes refletem a sua senioridade. O diretor gere um chefe de gabinete de IA, os gestores são treinadores-jogadores, executando objetivos eles próprios e treinando/outras pessoas sobre como manipular a IA com sucesso, o que reduz a amplitude de controlo pela metade.

Esta configuração reduz o número de funcionários (1:7:49 -> 1:7:14) em 53%.

O futuro não é uma solução única para todos.

Aqui está a reviravolta: nem todos os departamentos de uma empresa adotarão a mesma estrutura organizacional. O impacto da IA varia dramaticamente por função, criando um mundo onde a forma de uma empresa se torna mais nuançada do que nunca.

As equipas de vendas provavelmente manterão pirâmides tradicionais ou naves espaciais. As relações impulsionam a receita, e a empatia humana, criatividade e habilidades de negociação continuam a ser insubstituíveis. Os modelos clássicos de amplitude de controlo ainda se aplicam quando a confiança e o relacionamento são fundamentais.

As equipas de P&D apresentam a maior oportunidade para a transformação da pirâmide curta. A geração de código é o primeiro verdadeiro ajuste de produto-mercado da IA, gerando 50-80% do código para empresas líderes.

O sucesso e suporte ao cliente podem evoluir para modelos híbridos: a IA lida com consultas rotineiras enquanto os humanos gerem escalonamentos complexos e contas estratégicas. A camada tradicional de gestão intermédia transforma-se em algo completamente novo.

Esta evolução desafia tudo o que sabemos sobre como escalar equipas de forma eficaz. A antiga sabedoria de 6-7 relatórios diretos desmorona-se quando os gestores supervisionam tanto relatórios humanos como agentes de IA.

O fardo de recrutamento que historicamente justificava hierarquias de gestão também se transforma. Em vez de encontrar e desenvolver talento humano, os gestores concentram-se cada vez mais em configurar capacidades de IA e otimizar a colaboração humano-IA.

Se a empresa altera o seu organograma, que organograma imagina para a sua equipa?

1,18K

Um trilhão de tokens por dia. É muito?

"E quando olhamos de forma restrita apenas para o número de tokens servidos pelas APIs do Foundry, processamos mais de 100t de tokens neste trimestre, um aumento de 5x em relação ao ano anterior, incluindo um recorde de 50t de tokens apenas no mês passado."

Em abril, a Microsoft compartilhou uma estatística, revelando que seu produto Foundry está processando cerca de 1,7t de tokens por mês.

Ontem, Vipul compartilhou que está processando 2t de inferência de código aberto diariamente.

Em julho, o Google anunciou um número impressionante:

"Na I/O em maio, anunciamos que processamos 480 trilhões de tokens mensais em nossas superfícies. Desde então, dobramos esse número, agora processando mais de 980 trilhões de tokens mensais, um aumento notável."

O Google processa 32,7t diariamente, 16x mais do que o Together e 574x mais do que o volume de abril do Microsoft Foundry.

A partir desses números, podemos traçar algumas hipóteses:

1. A inferência de código aberto é uma fração de um único dígito da inferência. Não está claro qual fração dos tokens de inferência do Google vem de seus modelos de código aberto como o Gemma. Mas, se assumirmos que a Anthropic e a OpenAI estão em 5t-10t de tokens por dia e todos são de código fechado, além de que o Azure é aproximadamente semelhante em tamanho, então a inferência de código aberto provavelmente está em torno de 1-3% da inferência total.

2. Os agentes estão no início. O ponto de dados da Microsoft sugere que os agentes dentro do GitHub, Visual Studio, Copilot Studio e Microsoft Fabric contribuem com menos de 1% da inferência geral de IA no Azure.

3. Com a Microsoft prevista para investir $80 bilhões em comparação com os $85 bilhões do Google em infraestrutura de data center de IA este ano, as cargas de trabalho de inferência de IA de cada empresa devem aumentar significativamente, tanto através do hardware entrando em operação quanto das melhorias algorítmicas.

"Apenas através da otimização de software, estamos entregando 90% mais tokens para a mesma GPU em comparação com um ano atrás."

A Microsoft está extraindo mais limonada digital de suas GPUs e o Google também deve estar fazendo algo semelhante.

Quando veremos os primeiros 10t ou 50t de tokens de IA processados por dia? Não pode estar muito longe agora.

- Estimativas do nada!

- Google e Azure com 33t de tokens por dia cada, Together e 5 outras neoclouds com aproximadamente 2t de tokens por dia cada, e Anthropic e OpenAI com 5t de tokens por dia, nos dá 88t de tokens por dia. Se assumirmos que 5% dos tokens do Google vêm de modelos de código aberto, isso dá 1,65t de tokens por dia, ou aproximadamente 1,9% da inferência total. Novamente, matemática muito aproximada.

976

Top

Classificação

Favoritos