Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Tomasz Tunguz

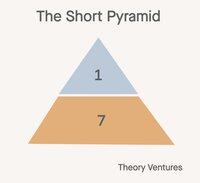

Oggi costruiamo team a piramide. Un leader, diversi manager, molti collaboratori individuali.

Nel mondo dell'AI, quale configurazione di team ha più senso? Ecco alcune alternative:

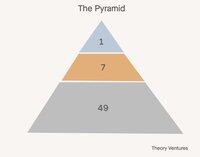

Prima, la piramide corta. I manager diventano manager di agenti. Il lavoro svolto dai collaboratori individuali di un tempo diventa il carico di lavoro degli agenti. Tutti si spostano a un livello di astrazione nel lavoro.

Questa configurazione riduce il numero di dipendenti dell'85% (1:7:49 -> 1:7). Il rapporto manager-collaboratore individuale passa da 1:7 a 1:1. Il rapporto manager-agente rimane 1:7.

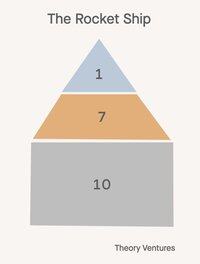

Secondo, il razzo 🚀!

Un direttore, sette manager, 21 dipendenti. Tutti nell'organizzazione gestiscono agenti, ma questi agenti riflettono la loro anzianità. Il direttore gestisce un capo di stato maggiore AI, i manager sono player-coach, eseguendo obiettivi e formando/allenando altri su come manipolare l'AI con successo, il che riduce il campo di controllo della metà.

Questa configurazione riduce il numero di dipendenti (1:7:49 -> 1:7:14) del 53%.

Il futuro non è una taglia unica.

Ecco il colpo di scena: non ogni dipartimento di un'azienda adotterà la stessa struttura organizzativa. L'impatto dell'AI varia drammaticamente in base alla funzione, creando un mondo in cui la forma di un'azienda diventa più sfumata che mai.

I team di vendita probabilmente manterranno piramidi tradizionali o razzi. Le relazioni guidano le entrate, e l'empatia umana, la creatività e le capacità di negoziazione rimangono insostituibili. I modelli classici di campo di controllo si applicano ancora quando fiducia e rapporto sono fondamentali.

I team di R&D presentano la maggiore opportunità per la trasformazione della piramide corta. La generazione di codice è il primo vero product-market fit dell'AI, generando il 50-80% del codice per le aziende leader.

Il successo e il supporto dei clienti potrebbero evolversi in modelli ibridi: l'AI gestisce le richieste di routine mentre gli esseri umani gestiscono le escalation complesse e gli account strategici. Il tradizionale strato di middle management si trasforma in qualcosa di completamente nuovo.

Questa evoluzione sfida tutto ciò che sappiamo su come scalare i team in modo efficace. La vecchia saggezza di 6-7 report diretti si rompe quando i manager supervisionano sia i report umani che gli agenti AI.

Il carico di reclutamento che storicamente giustificava le gerarchie di management si trasforma anch'esso. Invece di trovare e sviluppare talenti umani, i manager si concentrano sempre più sulla configurazione delle capacità dell'AI e sull'ottimizzazione della collaborazione uomo-AI.

Se l'azienda modifica il suo organigramma, quale organigramma immagini per il tuo team?

1,08K

Un trilione di token al giorno. È tanto?

“E quando guardiamo da vicino solo al numero di token serviti dalle API di Foundry, abbiamo elaborato oltre 100t token in questo trimestre, con un aumento di 5 volte rispetto all'anno precedente, inclusi un record di 50t token solo il mese scorso.”

Ad aprile, Microsoft ha condiviso una statistica, rivelando che il loro prodotto Foundry sta elaborando circa 1,7t token al mese.

Ieri, Vipul ha condiviso che sta elaborando 2t di inferenza open-source al giorno.

A luglio, Google ha annunciato un numero straordinario:

“Durante l'I/O di maggio, abbiamo annunciato che abbiamo elaborato 480 trilioni di token mensili attraverso le nostre superfici. Da allora abbiamo raddoppiato quel numero, ora elaborando oltre 980 trilioni di token mensili, un aumento notevole.”

Google elabora 32,7t al giorno, 16 volte di più rispetto a Together e 574 volte di più rispetto al volume di aprile di Microsoft Foundry.

Da queste cifre, possiamo trarre alcune ipotesi:

1. L'inferenza open-source è una frazione a una cifra dell'inferenza. Non è chiaro quale frazione dei token di inferenza di Google provenga dai loro modelli open source come Gemma. Ma, se assumiamo che Anthropic e OpenAI siano 5t-10t token al giorno e tutti closed-source, più Azure è grossomodo simile in dimensioni, allora l'inferenza open-source è probabilmente intorno all'1-3% dell'inferenza totale.

2. Gli agenti sono agli inizi. Il dato di Microsoft suggerisce che gli agenti all'interno di GitHub, Visual Studio, Copilot Studio e Microsoft Fabric contribuiscono a meno dell'1% dell'inferenza AI complessiva su Azure.

3. Con Microsoft che si prevede investirà 80 miliardi di dollari rispetto agli 85 miliardi di dollari di Google in infrastrutture di data center AI quest'anno, i carichi di lavoro di inferenza AI di ciascuna azienda dovrebbero aumentare significativamente sia attraverso l'hardware che entra in funzione sia attraverso miglioramenti algoritmici.

“Solo attraverso l'ottimizzazione del software, stiamo fornendo il 90% in più di token per lo stesso GPU rispetto a un anno fa.”

Microsoft sta spremendo più limonata digitale dai loro GPU e Google deve anche fare qualcosa di simile.

Quando vedremo i primi 10t o 50t di token AI elaborati al giorno? Non può essere lontano ora.

- Stime da un'idea!

- Google e Azure a 33t token al giorno ciascuno, Together e 5 altri neocloud a circa 2t token al giorno ciascuno, e Anthropic e OpenAI a 5t token al giorno, ci danno 88t token al giorno. Se assumiamo che il 5% dei token di Google provenga da modelli open-source, sono 1,65t token al giorno, o circa l'1,9% dell'inferenza totale. Di nuovo, matematica molto approssimativa.

891

Principali

Ranking

Preferiti