Chủ đề thịnh hành

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Tomasz Tunguz

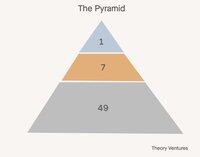

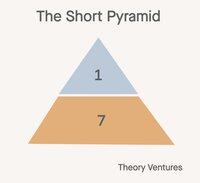

Chúng ta xây dựng các đội ngũ theo hình chóp ngày nay. Một lãnh đạo, vài quản lý, nhiều người đóng góp cá nhân.

Trong thế giới AI, cấu hình đội ngũ nào là hợp lý nhất? Dưới đây là một số lựa chọn:

Đầu tiên, hình chóp ngắn. Các quản lý trở thành quản lý đại lý. Công việc mà những người đóng góp cá nhân trước đây thực hiện trở thành khối lượng công việc của các đại lý. Mọi người đều nâng lên một cấp độ trừu tượng trong công việc.

Cấu hình này giảm số lượng nhân sự xuống 85% (1:7:49 -> 1:7). Tỷ lệ quản lý so với người đóng góp cá nhân giảm từ 1:7 xuống 1:1. Tỷ lệ quản lý so với đại lý vẫn giữ nguyên là 1:7.

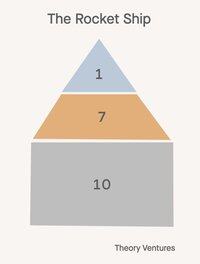

Thứ hai, tàu vũ trụ 🚀!

Một giám đốc, bảy quản lý, 21 nhân viên. Mọi người trong tổ chức đều quản lý các đại lý, nhưng những đại lý này phản ánh cấp bậc của họ. Giám đốc quản lý một trưởng phòng AI, các quản lý là những người chơi-huấn luyện viên, vừa thực hiện các mục tiêu của mình vừa đào tạo/hướng dẫn người khác cách thao tác AI thành công, điều này giảm một nửa phạm vi kiểm soát.

Cấu hình này giảm số lượng nhân sự (1:7:49 -> 1:7:14) xuống 53%.

Tương lai không phải là một kích thước phù hợp cho tất cả.

Đây là điều thú vị: không phải mọi phòng ban trong một công ty sẽ áp dụng cùng một cấu trúc tổ chức. Tác động của AI thay đổi đáng kể theo chức năng, tạo ra một thế giới mà hình dạng của một công ty trở nên tinh vi hơn bao giờ hết.

Các đội ngũ bán hàng có thể sẽ duy trì các hình chóp truyền thống hoặc tàu vũ trụ. Mối quan hệ thúc đẩy doanh thu, và sự đồng cảm của con người, sự sáng tạo và kỹ năng đàm phán vẫn không thể thay thế. Các mô hình phạm vi kiểm soát cổ điển vẫn áp dụng khi sự tin tưởng và mối quan hệ là điều tối quan trọng.

Các đội ngũ R&D mang đến cơ hội lớn nhất cho sự chuyển đổi hình chóp ngắn. Việc tạo mã là sản phẩm-thị trường đầu tiên thực sự của AI, tạo ra 50-80% mã cho các công ty hàng đầu.

Sự thành công và hỗ trợ khách hàng có thể phát triển thành các mô hình lai: AI xử lý các yêu cầu thông thường trong khi con người quản lý các tình huống phức tạp và các tài khoản chiến lược. Lớp quản lý trung gian truyền thống chuyển đổi thành một cái gì đó hoàn toàn mới.

Sự tiến hóa này thách thức mọi điều chúng ta biết về việc mở rộng các đội ngũ một cách hiệu quả. Những kiến thức cũ về 6-7 báo cáo trực tiếp bị phá vỡ khi các quản lý giám sát cả báo cáo con người và các đại lý AI.

Gánh nặng tuyển dụng mà trước đây biện minh cho các hệ thống quản lý cũng chuyển đổi. Thay vì tìm kiếm và phát triển tài năng con người, các quản lý ngày càng tập trung vào việc cấu hình khả năng AI và tối ưu hóa sự hợp tác giữa con người và AI.

Nếu công ty thay đổi sơ đồ tổ chức của mình, bạn hình dung sơ đồ tổ chức nào cho đội ngũ của bạn?

5,17K

Một triệu tỷ token mỗi ngày. Đó có phải là nhiều không?

"Và khi chúng ta nhìn một cách hẹp vào chỉ số lượng token được phục vụ bởi các API của Foundry, chúng tôi đã xử lý hơn 100t token trong quý này, tăng 5 lần so với năm trước, bao gồm một kỷ lục 50t token chỉ trong tháng trước."

Vào tháng Tư, Microsoft đã chia sẻ một thống kê, tiết lộ sản phẩm Foundry của họ đang xử lý khoảng 1.7t token mỗi tháng.

Hôm qua, Vipul đã chia sẻ rằng đang xử lý 2t suy diễn mã nguồn mở hàng ngày.

Vào tháng Bảy, Google đã công bố một con số đáng kinh ngạc:

"Tại I/O vào tháng Năm, chúng tôi đã thông báo rằng chúng tôi đã xử lý 480 triệu tỷ token hàng tháng trên các bề mặt của mình. Kể từ đó, chúng tôi đã gấp đôi con số đó, hiện đang xử lý hơn 980 triệu tỷ token hàng tháng, một sự gia tăng đáng kể."

Google xử lý 32.7t hàng ngày, gấp 16 lần Together và 574 lần khối lượng tháng Tư của Microsoft Foundry.

Từ những con số này, chúng ta có thể rút ra một vài giả thuyết:

1. Suy diễn mã nguồn mở chỉ chiếm một phần nhỏ trong suy diễn. Không rõ phần trăm nào trong số token suy diễn của Google đến từ các mô hình mã nguồn mở của họ như Gemma. Nhưng, nếu chúng ta giả định rằng Anthropic & OpenAI là 5t-10t token mỗi ngày và tất cả đều là mã nguồn đóng, cộng với Azure cũng tương tự về kích thước, thì suy diễn mã nguồn mở có thể chỉ khoảng 1-3% tổng số suy diễn.

2. Các tác nhân còn mới. Điểm dữ liệu của Microsoft cho thấy các tác nhân trong GitHub, Visual Studio, Copilot Studio và Microsoft Fabric đóng góp chưa đến 1% tổng số suy diễn AI trên Azure.

3. Với việc Microsoft dự kiến đầu tư 80 tỷ đô la so với 85 tỷ đô la của Google vào cơ sở hạ tầng trung tâm dữ liệu AI trong năm nay, khối lượng công việc suy diễn AI của mỗi công ty sẽ tăng đáng kể cả thông qua phần cứng được đưa vào hoạt động và cải tiến thuật toán.

"Chỉ thông qua tối ưu hóa phần mềm, chúng tôi đang cung cấp 90% nhiều token hơn cho cùng một GPU so với một năm trước."

Microsoft đang vắt nhiều nước chanh kỹ thuật số hơn từ các GPU của họ và Google cũng phải làm điều tương tự.

Khi nào chúng ta sẽ thấy 10t hoặc 50t token AI được xử lý mỗi ngày? Chắc chắn không còn xa nữa.

- Ước tính từ không khí!

- Google và Azure mỗi bên 33t token mỗi ngày, Together và 5 neocloud khác mỗi bên khoảng 2t token mỗi ngày, và Anthropic & OpenAI mỗi bên 5t token mỗi ngày, cho chúng ta 88t token mỗi ngày. Nếu chúng ta giả định 5% token của Google đến từ các mô hình mã nguồn mở, thì đó là 1.65t token mỗi ngày, hoặc khoảng 1.9% tổng số suy diễn. Một lần nữa, toán học rất thô.

5,52K

Hàng đầu

Thứ hạng

Yêu thích