Tendencias del momento

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Tomasz Tunguz

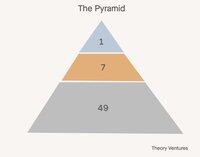

Hoy construimos equipos en pirámides. Un líder, varios gerentes, muchos colaboradores individuales.

En el mundo de la IA, ¿qué configuración de equipo tiene más sentido? Aquí hay algunas alternativas:

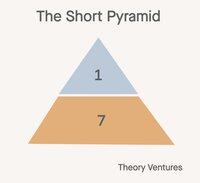

Primero, la pirámide corta. Los gerentes se convierten en gerentes de agentes. El trabajo realizado por los colaboradores individuales de antaño se convierte en las cargas de trabajo de los agentes. Todos suben un nivel de abstracción en el trabajo.

Esta configuración reduce el número de empleados en un 85% (1:7:49 -> 1:7). La relación entre gerentes y colaboradores individuales pasa de 1:7 a 1:1. La relación entre gerentes y agentes se mantiene en 1:7.

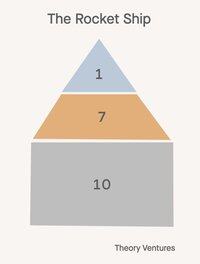

Segundo, ¡el cohete 🚀!

Un director, siete gerentes, 21 empleados. Todos en la organización están gestionando agentes, pero estos agentes reflejan su antigüedad. El director gestiona un jefe de personal de IA, los gerentes son entrenadores-jugadores, ejecutando objetivos ellos mismos y entrenando/coaching a otros sobre cómo manipular la IA con éxito, lo que reduce el alcance de control a la mitad.

Esta configuración reduce el número de empleados (1:7:49 -> 1:7:14) en un 53%.

El futuro no es una talla única.

Aquí está el giro: no todos los departamentos de una empresa adoptarán la misma estructura organizativa. El impacto de la IA varía drásticamente según la función, creando un mundo donde la forma de una empresa se vuelve más matizada que nunca.

Los equipos de ventas probablemente mantendrán pirámides tradicionales o cohetes. Las relaciones impulsan los ingresos, y la empatía humana, la creatividad y las habilidades de negociación siguen siendo insustituibles. Los modelos clásicos de alcance de control aún se aplican cuando la confianza y la relación son primordiales.

Los equipos de I+D presentan la mayor oportunidad para la transformación de la pirámide corta. La generación de código es el primer verdadero ajuste de producto-mercado de la IA, generando entre el 50% y el 80% del código para las empresas líderes.

El éxito y soporte al cliente podrían evolucionar hacia modelos híbridos: la IA maneja consultas rutinarias mientras que los humanos gestionan escalaciones complejas y cuentas estratégicas. La capa tradicional de gestión media se transforma en algo completamente nuevo.

Esta evolución desafía todo lo que sabemos sobre cómo escalar equipos de manera efectiva. La antigua sabiduría de 6-7 informes directos se descompone cuando los gerentes supervisan tanto informes humanos como agentes de IA.

La carga de reclutamiento que históricamente justificaba las jerarquías de gestión también se transforma. En lugar de encontrar y desarrollar talento humano, los gerentes se centran cada vez más en configurar capacidades de IA y optimizar la colaboración humano-IA.

Si la empresa envía su organigrama, ¿qué organigrama imaginas para tu equipo?

1,07K

Un billón de tokens por día. ¿Es eso mucho?

"Y cuando miramos de cerca solo el número de tokens servidos por las APIs de Foundry, procesamos más de 100 billones de tokens este trimestre, un aumento de 5 veces en comparación con el año anterior, incluyendo un récord de 50 billones de tokens solo el mes pasado."

En abril, Microsoft compartió una estadística, revelando que su producto Foundry está procesando alrededor de 1.7 billones de tokens por mes.

Ayer, Vipul compartió que está procesando 2 billones de inferencias de código abierto diariamente.

En julio, Google anunció un número asombroso:

"En I/O en mayo, anunciamos que procesamos 480 billones de tokens mensuales en nuestras superficies. Desde entonces hemos duplicado ese número, ahora procesando más de 980 billones de tokens mensuales, un aumento notable."

Google procesa 32.7 billones diariamente, 16 veces más que Together y 574 veces más que el volumen de abril de Microsoft Foundry.

A partir de estas cifras, podemos sacar algunas hipótesis:

1. La inferencia de código abierto es una fracción de un solo dígito de la inferencia. No está claro qué fracción de los tokens de inferencia de Google provienen de sus modelos de código abierto como Gemma. Pero, si asumimos que Anthropic y OpenAI son de 5 a 10 billones de tokens por día y todos son de código cerrado, además de que Azure es aproximadamente similar en tamaño, entonces la inferencia de código abierto probablemente sea alrededor del 1-3% de la inferencia total.

2. Los agentes están en una etapa temprana. El punto de datos de Microsoft sugiere que los agentes dentro de GitHub, Visual Studio, Copilot Studio y Microsoft Fabric contribuyen con menos del 1% de la inferencia total de IA en Azure.

3. Con Microsoft esperando invertir 80 mil millones en comparación con los 85 mil millones de Google en infraestructura de centros de datos de IA este año, las cargas de trabajo de inferencia de IA de cada empresa deberían aumentar significativamente tanto a través del hardware que se pone en línea como de las mejoras algorítmicas.

"A través de la optimización del software solo, estamos entregando un 90% más de tokens para la misma GPU en comparación con hace un año."

Microsoft está exprimiendo más limonada digital de sus GPUs y Google también debe estar haciendo algo similar.

¿Cuándo veremos los primeros 10 billones o 50 billones de tokens de IA procesados por día? No puede estar muy lejos ahora.

- ¡Estimaciones de la nada!

- Google y Azure en 33 billones de tokens por día cada uno, Together y 5 otras neoclouds en aproximadamente 2 billones de tokens por día cada uno, y Anthropic y OpenAI en 5 billones de tokens por día, nos da 88 billones de tokens por día. Si asumimos que el 5% de los tokens de Google provienen de modelos de código abierto, eso son 1.65 billones de tokens por día, o aproximadamente el 1.9% de la inferencia total. Nuevamente, matemáticas muy aproximadas.

886

Parte superior

Clasificación

Favoritos