Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Tomasz Tunguz

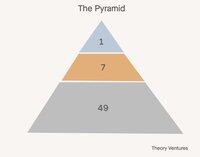

Dziś budujemy zespoły w piramidach. Jeden lider, kilku menedżerów, wielu indywidualnych współpracowników.

W świecie AI, jaka konfiguracja zespołu ma największy sens? Oto kilka alternatyw:

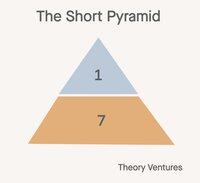

Po pierwsze, krótka piramida. Menedżerowie stają się menedżerami agentów. Praca wykonywana przez indywidualnych współpracowników w przeszłości staje się obciążeniem agentów. Wszyscy przesuwają się o poziom wyżej w pracy.

Ta konfiguracja redukuje liczbę etatów o 85% (1:7:49 -> 1:7). Stosunek menedżera do indywidualnego współpracownika zmienia się z 1:7 na 1:1. Stosunek menedżera do agenta pozostaje 1:7.

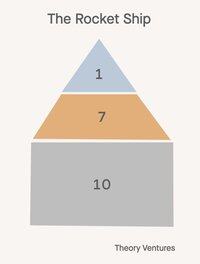

Po drugie, rakieta 🚀!

Jeden dyrektor, siedmiu menedżerów, 21 pracowników. Wszyscy w organizacji zarządzają agentami, ale ci agenci odzwierciedlają ich seniority. Dyrektor zarządza szefem sztabu AI, menedżerowie są trenerami-graczami, wykonując zarówno cele, jak i szkoląc/instruktażując innych, jak skutecznie manipulować AI, co zmniejsza zakres kontroli o połowę.

Ta konfiguracja redukuje liczbę etatów (1:7:49 -> 1:7:14) o 53%.

Przyszłość nie jest uniwersalna.

Oto zwrot akcji: nie każdy dział w firmie przyjmie tę samą strukturę organizacyjną. Wpływ AI różni się dramatycznie w zależności od funkcji, tworząc świat, w którym kształt firmy staje się bardziej zniuansowany niż kiedykolwiek.

Zespoły sprzedażowe prawdopodobnie będą utrzymywać tradycyjne piramidy lub rakiety. Relacje napędzają przychody, a ludzka empatia, kreatywność i umiejętności negocjacyjne pozostają niezastąpione. Klasyczne modele zakresu kontroli wciąż mają zastosowanie, gdy zaufanie i relacje są kluczowe.

Zespoły R&D stwarzają największą szansę na transformację krótkiej piramidy. Generowanie kodu to pierwszy prawdziwy produkt-rynkowy AI, generujący 50-80% kodu dla wiodących firm.

Sukces i wsparcie klientów mogą ewoluować w modele hybrydowe: AI obsługuje rutynowe zapytania, podczas gdy ludzie zarządzają złożonymi eskalacjami i strategicznymi kontami. Tradycyjna warstwa średniego zarządzania przekształca się w coś zupełnie nowego.

Ta ewolucja kwestionuje wszystko, co wiemy o skutecznym skalowaniu zespołów. Stara mądrość o 6-7 bezpośrednich raportach rozpada się, gdy menedżerowie nadzorują zarówno ludzkie raporty, jak i agentów AI.

Obciążenie rekrutacyjne, które historycznie uzasadniało hierarchie zarządzania, również się zmienia. Zamiast znajdować i rozwijać ludzkie talenty, menedżerowie coraz bardziej koncentrują się na konfigurowaniu możliwości AI i optymalizacji współpracy człowiek-AI.

Jeśli firma zmienia swoją strukturę organizacyjną, jaką strukturę organizacyjną wyobrażasz sobie dla swojego zespołu?

1,1K

Jedna bilion tokenów dziennie. Czy to dużo?

„A kiedy patrzymy wąsko tylko na liczbę tokenów obsługiwanych przez API Foundry, przetworzyliśmy w tym kwartale ponad 100t tokenów, co oznacza wzrost o 5x w porównaniu do roku ubiegłego, w tym rekordowe 50t tokenów tylko w zeszłym miesiącu.”

W kwietniu Microsoft podzielił się statystyką, ujawniając, że ich produkt Foundry przetwarza około 1,7t tokenów miesięcznie.

Wczoraj Vipul podzielił się informacją, że przetwarza 2t otwartych inferencji dziennie.

W lipcu Google ogłosił oszałamiającą liczbę:

„Na I/O w maju ogłosiliśmy, że przetwarzamy 480 bilionów tokenów miesięcznie na naszych platformach. Od tego czasu podwoiliśmy tę liczbę, przetwarzając teraz ponad 980 bilionów tokenów miesięcznie, co stanowi niezwykły wzrost.”

Google przetwarza 32,7t dziennie, 16 razy więcej niż Together i 574 razy więcej niż wolumen Microsoft Foundry z kwietnia.

Na podstawie tych danych możemy wyciągnąć kilka hipotez:

1. Otwarta inferencja to jednocyfrowa frakcja inferencji. Nie jest jasne, jaka frakcja tokenów inferencyjnych Google pochodzi z ich modeli open source, takich jak Gemma. Ale jeśli założymy, że Anthropic i OpenAI to 5t-10t tokenów dziennie i są całkowicie zamknięte, a Azure jest mniej więcej podobnej wielkości, to otwarta inferencja prawdopodobnie stanowi około 1-3% całkowitej inferencji.

2. Agenci są na wczesnym etapie. Punkt danych Microsoftu sugeruje, że agenci w GitHubie, Visual Studio, Copilot Studio i Microsoft Fabric przyczyniają się do mniej niż 1% całkowitej inferencji AI na Azure.

3. Oczekuje się, że Microsoft zainwestuje 80 miliardów dolarów w porównaniu do 85 miliardów dolarów Google w infrastrukturę centrów danych AI w tym roku, co powinno znacząco zwiększyć obciążenia inferencyjne każdej firmy zarówno dzięki nowemu sprzętowi, jak i poprawom algorytmicznym.

„Dzięki optymalizacji oprogramowania dostarczamy 90% więcej tokenów na tym samym GPU w porównaniu do roku ubiegłego.”

Microsoft wyciska więcej cyfrowej lemoniady ze swoich GPU, a Google również musi robić coś podobnego.

Kiedy zobaczymy pierwsze 10t lub 50t tokenów AI przetwarzanych dziennie? To nie może być daleko.

- Szacunki z powietrza!

- Google i Azure po 33t tokenów dziennie każdy, Together i 5 innych neokloudów po około 2t tokenów dziennie każdy, oraz Anthropic i OpenAI po 5t tokenów dziennie, daje nam 88t tokenów dziennie. Jeśli założymy, że 5% tokenów Google pochodzi z modeli open source, to daje nam 1,65t tokenów dziennie, czyli około 1,9% całkowitej inferencji. Jeszcze raz, bardzo przybliżone obliczenia.

912

Najlepsze

Ranking

Ulubione