Populární témata

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Někdy umělá inteligence řekne špatnou věc, ne proto, že by to bylo hloupé, ale proto, že ji nikdo nevolá k odpovědnosti.

Použil jsem mnoho "nástrojů umělé inteligence", psal jsem rychle a slušně kreslil, ale pokaždé, když vidím, že to vážně shromažďuje data a mluví o logice, chápu jednu věc: generování není nikdy problém; Ověření je prahová hodnota.

Proto mi na @Mira_Network záleží.

Nechce být dalším ChatGPT, ani nechce tahat za sebou spoustu GPU, aby se zapojily do rozumových soutěží. Přímo klade otázku z jiné perspektivy – jak můžeme věřit výstupům AI?

Mirova odpověď nezní "máme silnější model", ale: "Pokud chcete, aby umělá inteligence mluvila, musíte ji přimět, aby byla kontrolována, byla zodpovědná a byla prokázána." ”

Pomocí umělé inteligence vygenerujete obsah v ekosystému Mira, který bude rozdělen na řadu malých úsudků a předhozen několika uzlům k ověření.

Použijete ho k napsání odstavce, hledání definice, vygenerování diagramu a on vám řekne: kdo tento závěr dal, zda existuje konsensus a zda je důvěryhodný.

V minulosti, když jste umělou inteligenci používali, poslouchali jste ji, jak vypráví příběhy. Teď s Mirou vidíte, jak se to obrací v domácím úkolu.

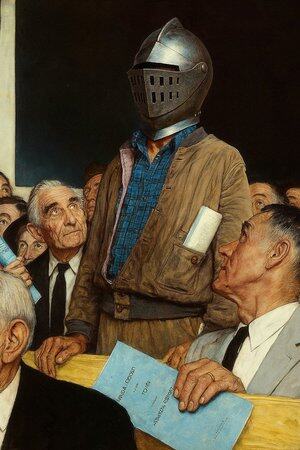

Takže říkám, že to není aplikace AI, je to spíš "AI mluvící soud".

Samozřejmě můžete i nadále používat umělou inteligenci k psaní, kreslení a vyhledávání materiálů, ale když tato věc začne diktovat lékařské rady, smluvní podmínky, důkazy ze soudních sporů, měli byste mít místo, kde to může někdo podpořit za každé slovo.

Mira je jedním z takových míst. Nejde o to posuzovat za vás, ale o to, aby to, co vidíte, nebylo vytvořeno umělou inteligencí.

@KaitoAI

Top

Hodnocení

Oblíbené