Trendande ämnen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Ibland säger AI fel sak, inte för att den är dum, utan för att ingen håller den ansvarig.

Jag har använt många "AI-verktyg", skrivit snabbt och ritat hyfsat, men varje gång jag ser det på allvar sammanställa data och prata om logik förstår jag en sak: generering är aldrig ett problem; Verifiering är tröskeln.

Det är därför jag bryr mig om @Mira_Network.

Den vill inte bli nästa ChatGPT, och den vill inte heller dra en massa GPU:er för att delta i resonemangstävlingar. Den ställer direkt frågan från ett annat perspektiv - hur kan vi lita på resultatet av AI?

Miras svar är inte "vi har en starkare modell", utan: "Om du vill att AI ska tala måste du få den att kontrollera, hållas ansvarig och bevisas." ”

Du använder AI för att generera ett innehåll i Mira-ekosystemet, som kommer att brytas ner i en serie små bedömningar och kastas till flera noder för verifiering.

Du använder den för att skriva ett stycke, söka efter en definition, generera ett diagram, och det kommer att berätta för dig: vem som gav denna slutsats, om det finns en konsensus och om den är trovärdig.

Förr i tiden, när man använde AI, lyssnade man på hur den berättade historier. Nu med Mira ser du att det blir läxor.

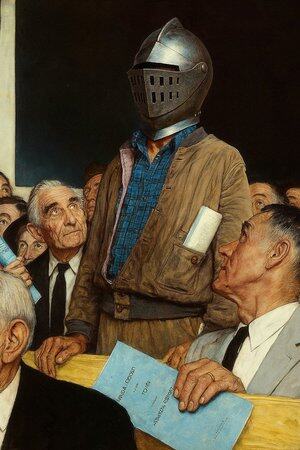

Så jag säger att det inte är en AI-applikation, det är mer som en "AI talking court".

Naturligtvis kan du fortsätta att använda AI för att skriva, rita och hitta material, men när den här saken börjar diktera medicinsk rådgivning, avtalsvillkor och rättegångsbevis, bör du ha en plats där den kan godkännas av någon för varje ord.

Mira är en sådan plats. Det handlar inte om att döma åt dig, utan om att se till att det du ser inte är påhittat av AI.

@KaitoAI

Topp

Rankning

Favoriter