Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Czasami AI mówi coś złego, nie dlatego, że jest głupie, ale dlatego, że nikt nie wymaga od niego odpowiedzialności.

Używałem wielu "narzędzi AI", które piszą szybko i rysują przyzwoicie, ale za każdym razem, gdy widzę, jak poważnie generują dane i mówią bzdury, rozumiem jedną rzecz: generowanie nigdy nie było problemem; weryfikacja to prawdziwa przeszkoda.

Dlatego właśnie interesuję się @Mira_Network.

Nie chce być kolejnym ChatGPT, ani nie zamierza ściągać masy GPU do rywalizacji w wnioskowaniu. Zadaje po prostu inne pytanie - jak możemy ufać wynikom AI?

Odpowiedź, którą daje Mira, nie brzmi: "mamy silniejszy model", ale: "jeśli chcesz, aby AI mówiło, musisz sprawić, aby mogło być weryfikowane, pociągane do odpowiedzialności i udowodnione."

Kiedy używasz AI w ekosystemie Mira do generowania treści, rozdziela to na szereg małych osądów, które są weryfikowane przez wiele węzłów, proces zapisuje na łańcuchu, wyniki są konsensualne, a błędy kosztują.

Pisząc coś, szukając definicji, generując obrazek, obok będzie informacja: na kim opiera się ten wniosek, czy jest konsensus, czy jest wiarygodny.

Kiedyś używało się AI, aby słuchać, jak opowiada historie. Teraz, używając Miry, widzisz, jak wykonuje zadania.

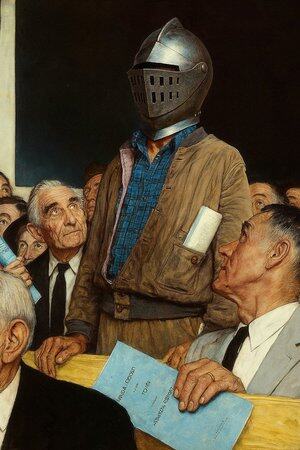

Dlatego mówię, że to nie jest aplikacja AI, to bardziej "sąd, w którym AI mówi".

Oczywiście możesz nadal używać AI do pisania artykułów, rysowania, szukania materiałów, ale gdy to zaczyna decydować o zaleceniach medycznych, warunkach umowy, dowodach w sprawach sądowych, lepiej mieć miejsce, które zapewnia, że każda jego wypowiedź ma poparcie.

Mira to takie miejsce. Nie zastępuje twojego osądu, ale zapewnia, że to, co widzisz, nie jest wymyślone przez AI.

@KaitoAI

Najlepsze

Ranking

Ulubione