Trendaavat aiheet

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Joskus tekoäly sanoo väärän asian, ei siksi, että se olisi tyhmää, vaan siksi, että kukaan ei pidä sitä vastuullisena.

Olen käyttänyt monia "tekoälytyökaluja", kirjoittanut nopeasti ja piirtänyt kunnollisesti, mutta joka kerta kun näen sen kokoavan vakavasti dataa ja puhuvan logiikasta, ymmärrän yhden asian: sukupolvi ei ole koskaan ongelma; Todentaminen on kynnysarvo.

Siksi välitän @Mira_Network.

Se ei halua olla seuraava ChatGPT, eikä se halua vetää joukkoa GPU:ita osallistuakseen päättelykilpailuihin. Se kysyy suoraan kysymyksen eri näkökulmasta - kuinka voimme luottaa tekoälyn tuloksiin?

Miran vastaus ei ole "meillä on vahvempi malli", vaan: "Jos haluat tekoälyn puhuvan, sinun on saatava se tarkistamaan, saatettava vastuuseen ja todistettava." ”

Tekoälyn avulla luot Mira-ekosysteemiin sisällön, joka jaetaan sarjaan pieniä tuomioita ja heitetään useisiin solmuihin tarkistettavaksi.

Käytät sitä kappaleen kirjoittamiseen, määritelmän etsimiseen, kaavion luomiseen, ja se kertoo sinulle: kuka teki tämän johtopäätöksen, onko konsensus olemassa ja onko se uskottava.

Aiemmin, kun käytit tekoälyä, kuuntelit sen kertovan tarinoita. Nyt Miran kanssa näet sen kääntyvän läksyissä.

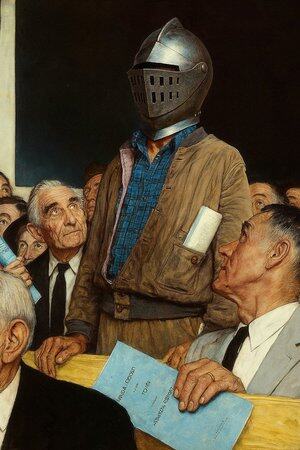

Joten sanon, että se ei ole tekoälysovellus, se on enemmän kuin "tekoälyn puhuva tuomioistuin".

Voit tietysti jatkaa tekoälyn käyttöä kirjoittamiseen, piirtämiseen ja materiaalien etsimiseen, mutta kun tämä asia alkaa sanella lääketieteellisiä neuvoja, sopimusehtoja ja oikeudenkäyntitodisteita, sinulla on parempi olla paikka, jossa joku voi tukea sitä jokaisesta sanasta.

Mira on yksi tällainen paikka. Kyse ei ole tuomitsemisesta puolestasi, vaan sen varmistamisesta, että näkemäsi ei ole tekoälyn keksimää.

@KaitoAI

Johtavat

Rankkaus

Suosikit