熱門話題

#

Bonk 生態迷因幣展現強韌勢頭

#

有消息稱 Pump.fun 計劃 40 億估值發幣,引發市場猜測

#

Solana 新代幣發射平臺 Boop.Fun 風頭正勁

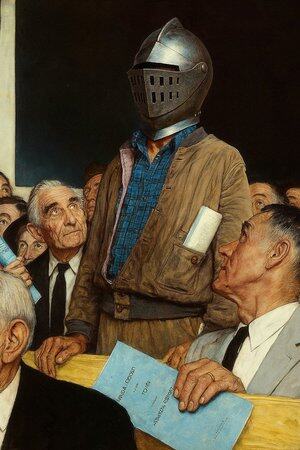

有時候AI說錯話,不是因為它蠢,而是因為沒人要求它負責。

我用過很多“AI工具”,寫得飛快、畫得像樣,但每次看到它一本正經地編數據、亂講邏輯,我就明白一個事:生成,從來不是問題;驗證,才是門檻。

這就是我為什麼對@Mira_Network上心的原因。

它不是想做下一個ChatGPT,也不是想拉一堆GPU搞推理競賽。它是直接換個角度問了一個問題——我們怎麼能信任AI的輸出?

Mira 給的答案不是“我們有個更強模型”,而是:“你想讓AI說話,那就得讓它能被查、能被問責、能被證明。”

你在 Mira 生態裡用AI生成一段內容,它會拆成一連串小判斷,丟給多個節點去驗證,過程寫鏈、結果共識、錯誤要賠錢。

你用它寫段話、搜個定義、生成一張圖,旁邊會告訴你:這個結論靠誰給的、有沒有共識、是不是可信。

以前用AI,是你聽它講故事。現在用Mira,是你看它交作業。

所以我說它不是AI應用,它更像是個“AI說話的法庭”。

你當然可以繼續用AI寫稿、畫畫、找素材,但當這東西開始決定醫療建議、合同條款、訴訟證據時,你最好有一個地方,能讓它的每一句話都有人背書。

Mira 就是這麼一個地方。不是替你判斷,而是確保你看到的,不是AI編的。

@KaitoAI

熱門

排行

收藏