Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

A volte l'AI dice cose sbagliate, non perché sia stupida, ma perché nessuno le chiede di assumersi la responsabilità.

Ho usato molti "strumenti AI", scrivono velocemente e disegnano decentemente, ma ogni volta che la vedo seriamente inventare dati e parlare a vanvera di logica, capisco una cosa: generare non è mai stato un problema; verificare, invece, è la vera sfida.

Ecco perché sono interessato a @Mira_Network.

Non vuole essere il prossimo ChatGPT, né vuole radunare un sacco di GPU per una competizione di inferenza. Ha semplicemente posto una domanda da un'altra angolazione: come possiamo fidarci delle uscite dell'AI?

La risposta di Mira non è "abbiamo un modello più potente", ma: "se vuoi che l'AI parli, devi far sì che possa essere verificata, interrogata e dimostrata."

Quando usi l'AI per generare un contenuto nell'ecosistema di Mira, questo verrà scomposto in una serie di piccoli giudizi, inviati a più nodi per la verifica, il processo scrive la catena, il risultato è consenso, e gli errori devono essere risarciti.

Se lo usi per scrivere un testo, cercare una definizione o generare un'immagine, ti dirà accanto: su chi si basa questa conclusione, se c'è consenso, se è affidabile.

In passato, usavi l'AI per ascoltarla raccontare storie. Ora, usando Mira, la vedi fare i compiti.

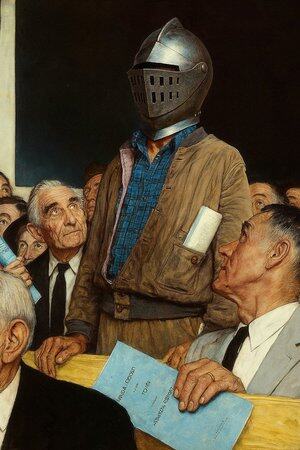

Quindi dico che non è un'applicazione AI, è più come un "tribunale per l'AI".

Puoi certamente continuare a usare l'AI per scrivere articoli, disegnare, cercare materiali, ma quando questa cosa inizia a decidere consigli medici, clausole contrattuali, prove di contenzioso, è meglio avere un posto dove ogni sua parola possa essere avallata.

Mira è proprio quel posto. Non sostituisce il tuo giudizio, ma assicura che ciò che vedi non sia inventato dall'AI.

@KaitoAI

Principali

Ranking

Preferiti