トレンドトピック

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

AI が間違ったことを言うことがありますが、それは愚かだからではなく、誰も責任を負わないためです。

私は多くの「AI ツール」を使用して、素早く書き、まともに描いてきましたが、真剣にデータを編集し、論理について話しているのを見るたびに、生成は決して問題ではないということが 1 つ理解できます。 検証はしきい値です。

だからこそ、私は@Mira_Networkを気にかけています。

次の ChatGPT になりたくありませんし、推論競争に参加するために大量の GPU を引っ張りたくもありません。 それは、AI の出力をどのように信頼できるかという別の視点から直接質問を投げかけます。

ミラの答えは「私たちにはより強力なモデルがある」ではなく、「AIに話してもらいたいなら、AIをチェックし、責任を問われ、証明されなければならない」というものです。 ”

AI を使用して Mira エコシステム内のコンテンツを生成し、それを一連の小さな判断に分割し、検証のために複数のノードに投げます。

これを使用して段落を書いたり、定義を検索したり、図を作成したりすると、誰がこの結論を下したのか、コンセンサスがあるのか、信頼できるのかがわかります。

以前は、AI を使用するときは、AI が物語を語るのを聞いていました。 ミラでは、宿題が返されるのがわかります。

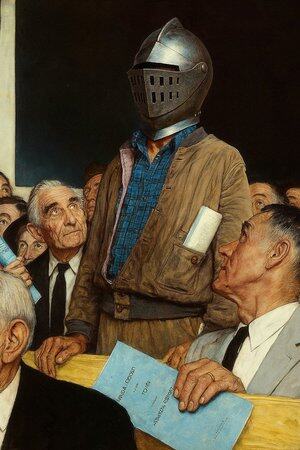

だから私は、これはAIアプリケーションではなく、「AIトーキングコート」のようなものだと言います。

もちろん、AI を使用して資料を書いたり、描いたり、見つけたりすることはできますが、これが医学的アドバイス、契約条件、訴訟証拠を指示し始めたら、すべての単語で誰かに承認できる場所を確保したほうがよいでしょう。

ミラもそのような場所の1つです。 それはあなたのために判断することではなく、あなたが見ているものがAIによってでっち上げられていないことを確認することです。

@KaitoAI

トップ

ランキング

お気に入り