Populární témata

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

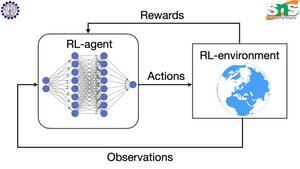

Jak funguje backprop s RL?

Předností backprop je, že aktualizuje KAŽDÝ jednotlivý parametr v poměru k tomu, jak moc se kroutí To je možné pouze tehdy, pokud víte, jak změna jednotlivých parametrů ovlivňuje ztrátovou funkci.

Ale u RL tomu tak samozřejmě není: prostředí (a odměna, kterou produkuje) je zcela oddělený systém. Nemáte nějakou spojitou diferencovatelnou funkci, která vám řekne, jak moc kroucení každého parametru ovlivňuje pravděpodobnost pádu z útesu.

Řešení jsou docela chytrá! Zde je několik způsobů, jak přijít s diferencovatelným zástupcem odměny:

Metody gradientu zásad: Nemůžete rozlišovat odměnu s ohledem na síť. Můžete však rozlišovat pravděpodobnosti různých akcí/tokenů navržených sítí. Takže prostě udělejme ztrátu = (součet záporných logů) pravděpodobností VÁŽENÝCH odměnou. Ztráta je vyšší, když je odměna nižší, takže model se učí vydávat tokeny, což vede k vyšší odměně s vyšší pravděpodobností.

Q-learning: Opět platí, že odměna není diferencovatelná s ohledem na síť. Ale víte, co to je? Predikce odměny ze strany sítě. A můžete ji aktualizovat na základě toho, jak špatná byla tato předpověď. Nyní, když můžete předvídat, jaké akce povedou k jaké odměně, může být vaší zásadou jednoduše provést akce s nejvyšší očekávanou odměnou.

Top

Hodnocení

Oblíbené