Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

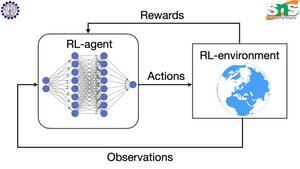

Wie funktioniert Backpropagation mit RL?

Der Vorteil von Backpropagation ist, dass es JEDEN einzelnen Parameter in dem Maße aktualisiert, wie viel er den Verlust beeinflusst. Dies ist nur möglich, wenn man weiß, wie sich die Änderung jedes Parameters auf die Verlustfunktion auswirkt.

Aber natürlich ist das bei RL nicht der Fall: Die Umgebung (und die Belohnung, die sie produziert) ist ein ganz separates System. Man hat keine kontinuierliche differenzierbare Funktion, die einem sagt, wie viel das Wackeln jedes Parameters die Wahrscheinlichkeit beeinflusst, von einer Klippe zu fallen.

Die Lösungen sind ziemlich clever! Hier sind einige Möglichkeiten, um einen differenzierbaren Proxy für die Belohnung zu finden:

Policy-Gradient-Methoden: Man kann die Belohnung nicht in Bezug auf das Netzwerk differenzieren. Aber man kann die Wahrscheinlichkeiten verschiedener Aktionen/Tokens, die vom Netzwerk vorgeschlagen werden, differenzieren. Also macht man einfach den Verlust = die (Summe der negativen Logarithmen) der Wahrscheinlichkeiten, GEWICHTET nach der Belohnung. Der Verlust ist höher, wenn die Belohnung niedriger ist, sodass das Modell lernt, Tokens auszugeben, die zu einer höheren Belohnung mit höherer Wahrscheinlichkeit führen.

Q-Learning: Wiederum ist die Belohnung nicht differenzierbar in Bezug auf das Netzwerk. Aber was ist differenzierbar? Die Vorhersage des Netzwerks für die Belohnung. Und man kann sie basierend darauf aktualisieren, wie falsch diese Vorhersage war. Jetzt, da man vorhersagen kann, welche Aktionen zu welcher Belohnung führen, kann die Strategie einfach darin bestehen, die Aktionen mit der höchsten erwarteten Belohnung zu wählen.

Top

Ranking

Favoriten