Актуальні теми

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

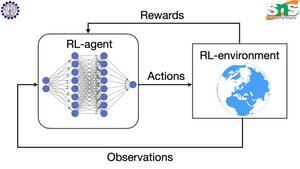

Як backprop працює з RL?

Перевага backprop полягає в тому, що він оновлює КОЖЕН окремий параметр пропорційно до того, наскільки сильно він впливає на втрату. Це можливо тільки в тому випадку, якщо ви знаєте, як зміна кожного параметра впливає на функцію втрат.

Але, звичайно, з RL це не так: середовище (і винагорода, яку вона виробляє) - це ціла окрема система. У вас немає якоїсь безперервної диференційовної функції, яка повідомляє вам, наскільки хитання кожного параметра впливає на ймовірність падіння зі скелі.

Рішення досить розумні! Ось кілька способів придумати диференційований проксі для винагороди:

Методи градієнта політики: Ви не можете диференціювати винагороду по відношенню до мережі. Але ви можете диференціювати ймовірності різних дій/токенів, запропонованих мережею. Отже, просто зробіть збиток = (сума від'ємного log) ймовірностей, ЗВАЖЕНИХ на винагороду. Втрати вищі, коли винагорода нижча, тому модель вчиться виводити токени, які призводять до вищої винагороди з більшою ймовірністю.

Q-навчання: Знову ж таки, винагорода не є диференційованою по відношенню до мережі. Але знаєте, що таке? Прогноз мережі щодо винагороди. І ви можете оновити його залежно від того, наскільки неправильним був цей прогноз. Тепер, коли ви можете передбачити, які дії призведуть до якої винагороди, ваша політика може полягати лише в тому, щоб робити дії з найвищою очікуваною винагородою.

Найкращі

Рейтинг

Вибране