Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

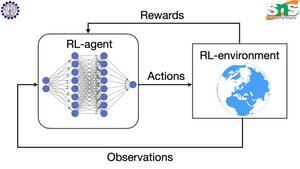

Hvordan fungerer backprop med RL?

Fordelen med backprop er at den oppdaterer HVER enkelt parameter i forhold til hvor mye vrikking den påvirker tapet. Dette er bare mulig hvis du vet hvordan endring av hver parameter påvirker tapsfunksjonen.

Men selvfølgelig er dette ikke tilfelle med RL: miljøet (og belønningen det produserer) er et helt eget system. Du har ikke noen kontinuerlig differensierbar funksjon som forteller deg hvor mye vrikking hver parameter påvirker sannsynligheten for å falle utfor en klippe.

Løsningene er ganske smarte! Her er noen måter å komme opp med en differensierbar proxy for belønning:

Metoder for graduering av retningslinjer: Du kan ikke skille belønningen i forhold til nettverket. Men du kan skille sannsynlighetene for forskjellige handlinger/tokens foreslått av nettverket. Så bare gjør tapet = (summen av negativ log) sannsynligheten VEKTET av belønningen. Tapet er høyere når belønningen er lavere, så modellen lærer å sende ut tokens som fører til høyere belønning med høyere sannsynlighet.

Q-læring: Igjen, belønning er ikke differensierbar med hensyn til nettverket. Men vet du hva som er det? Nettverkets prediksjon av belønningen. Og du kan oppdatere den basert på hvor feil den spådommen var. Nå som du kan forutsi hvilke handlinger som vil føre til hvilken belønning, kan policyen din ganske enkelt bare være å ta de høyeste forventede belønningshandlingene.

Topp

Rangering

Favoritter