Trendande ämnen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

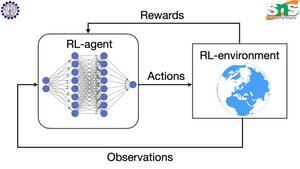

Hur fungerar backprop med RL?

Fördelen med backprop är att den uppdaterar VARJE enskild parameter i proportion till hur mycket vickning den påverkar förlusten. Detta är bara möjligt om du vet hur en ändring av varje parameter påverkar förlustfunktionen.

Men med RL är detta naturligtvis inte fallet: miljön (och den belöning den producerar) är ett helt separat system. Du har inte någon kontinuerlig differentierbar funktion som talar om hur mycket vickning varje parameter påverkar sannolikheten för att falla från en klippa.

Lösningarna är ganska smarta! Här är några sätt att komma på en differentierbar proxy för belöning:

Principgradientmetoder: Du kan inte särskilja belöningen med avseende på nätverket. Men du kan differentiera sannolikheterna för olika åtgärder/tokens som föreslås av nätverket. Så det är bara att göra förlusten = (summan av den negativa loggen) sannolikheterna viktade med belöningen. Förlusten är högre när belöningen är lägre, så modellen lär sig att mata ut token, vilket leder till högre belöning med högre sannolikhet.

Q-learning: Återigen, belöning är inte differentierbar med avseende på nätverket. Men vet du vad som är det? Nätverkets förutsägelse av belöningen. Och du kan uppdatera den baserat på hur fel den förutsägelsen var. Nu när du kan förutsäga vilka åtgärder som kommer att leda till vilken belöning kan din policy helt enkelt vara att vidta de högsta förväntade belöningsåtgärderna.

Topp

Rankning

Favoriter