Tópicos populares

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Como funciona o backprop com RL?

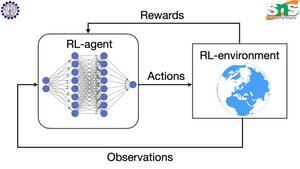

A virtude do backprop é que ele atualiza CADA parâmetro individual em proporção a quanto ele afeta a perda. Isso só é possível se você souber como a alteração de cada parâmetro afeta a função de perda.

Mas, claro, com RL isso não é o caso: o ambiente (e a recompensa que ele produz) é um sistema completamente separado. Você não tem uma função contínua e diferenciável que lhe diga quanto a alteração de cada parâmetro afeta a probabilidade de cair de um penhasco.

As soluções são bastante inteligentes! Aqui estão algumas maneiras de criar um proxy diferenciável para a recompensa:

Métodos de gradiente de política: Você não pode diferenciar a recompensa em relação à rede. Mas você pode diferenciar as probabilidades de diferentes ações/tokens sugeridos pela rede. Então, basta fazer a perda = a (soma do log negativo) das probabilidades PESADAS pela recompensa. A perda é maior quando a recompensa é menor, então o modelo aprende a gerar tokens que levam a uma recompensa maior com maior probabilidade.

Q-learning: Novamente, a recompensa não é diferenciável em relação à rede. Mas você sabe o que é? A previsão da recompensa pela rede. E você pode atualizá-la com base em quão errada essa previsão estava. Agora que você pode prever quais ações levarão a qual recompensa, sua política pode simplesmente ser tomar as ações de maior recompensa esperada.

Top

Classificação

Favoritos