熱門話題

#

Bonk 生態迷因幣展現強韌勢頭

#

有消息稱 Pump.fun 計劃 40 億估值發幣,引發市場猜測

#

Solana 新代幣發射平臺 Boop.Fun 風頭正勁

反向傳播在強化學習中是如何工作的?

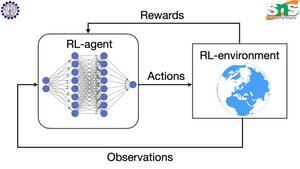

反向傳播的優點在於它根據每個參數對損失的影響程度來更新每個單獨的參數。這只有在你知道改變每個參數如何影響損失函數的情況下才有可能。

但在強化學習中情況並非如此:環境(以及它產生的獎勵)是一個完全獨立的系統。你沒有某個連續可微的函數來告訴你每個參數的微小變化對掉下懸崖的概率有多大影響。

解決方案非常巧妙!以下是一些為獎勵提供可微代理的方法:

策略梯度方法:你無法對網絡的獎勵進行微分。但你可以對網絡建議的不同動作/標記的概率進行微分。因此,只需將損失設置為(負對數的總和)乘以獎勵的加權。獎勵越低,損失越高,因此模型學習輸出導致更高獎勵的標記,並且概率更高。

Q學習:同樣,獎勵與網絡的關係不可微分。但你知道什麼是可微分的?網絡對獎勵的預測。你可以根據該預測的錯誤程度來更新它。現在你可以預測哪些動作會導致什麼獎勵,你的策略可以簡單地是採取預期獎勵最高的動作。

熱門

排行

收藏