Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Hoe werkt backprop met RL?

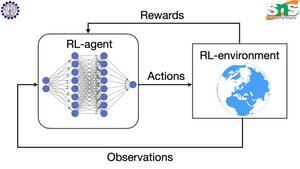

De deugd van backprop is dat het ELKE individuele parameter bijwerkt in verhouding tot hoeveel wiggelen het de verliesfunctie beïnvloedt. Dit is alleen mogelijk als je weet hoe het veranderen van elke parameter de verliesfunctie beïnvloedt.

Maar natuurlijk is dit met RL niet het geval: de omgeving (en de beloning die het produceert) is een geheel apart systeem. Je hebt geen continue differentieerbare functie die je vertelt hoeveel wiggelen van elke parameter de kans beïnvloedt om van een klif te vallen.

De oplossingen zijn behoorlijk slim! Hier zijn enkele manieren om een differentieerbare proxy voor beloning te bedenken:

Beleidsgraadmethoden: Je kunt de beloning niet differentiëren ten opzichte van het netwerk. Maar je kunt de kansen van verschillende acties/tokens die door het netwerk worden voorgesteld, differentiëren. Maak de verliesfunctie dus gelijk aan de (som van negatieve log) kansen GEWICHT door de beloning. Het verlies is hoger wanneer de beloning lager is, zodat het model leert om tokens uit te geven die leiden tot een hogere beloning met een hogere kans.

Q-learning: Nogmaals, de beloning is niet differentieerbaar ten opzichte van het netwerk. Maar wat wel differentieerbaar is? De voorspelling van de beloning door het netwerk. En je kunt het bijwerken op basis van hoe fout die voorspelling was. Nu je kunt voorspellen welke acties tot welke beloning leiden, kan je beleid simpelweg zijn om de acties met de hoogste verwachte beloning te nemen.

Boven

Positie

Favorieten