トレンドトピック

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

backpropはRLでどのように機能しますか?

backprop の利点は、損失にどれだけ小刻みに動くかに比例して、個々のパラメーターを更新することです。これは、各パラメータの変更が損失関数にどのように影響するかを知っている場合にのみ可能です。

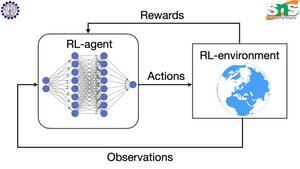

しかし、もちろんRLではそうではありません:環境(およびそれが生み出す報酬)はまったく別のシステムです。各パラメータが崖から落ちる確率にどの程度の小刻みに動くかを示す連続微分関数はありません。

解決策は非常に賢いです!報酬の差別化可能なプロキシを考え出す方法をいくつか紹介します。

ポリシー勾配方法: ネットワークに関して報酬を区別することはできません。ただし、ネットワークによって提案されたさまざまなアクション/トークンの確率を区別することはできます。したがって、損失=(負の対数の合計)確率を報酬で重み付けします。報酬が低いほど損失が高くなるため、モデルはトークンを出力することを学習し、より高い確率でより高い報酬につながります。

Q-learning:繰り返しになりますが、報酬はネットワークに関して微分できません。しかし、何がそうであるか知っていますか?ネットワークによる報酬の予測。そして、その予測がどれほど間違っていたかに基づいて更新することができます。どのような行動がどのような報酬につながるかを予測できるようになったので、あなたのポリシーは、単に期待される最も高い報酬の行動を取ることにすることができます。

トップ

ランキング

お気に入り