Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

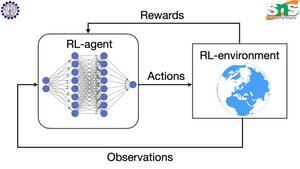

Come funziona il backprop con RL?

Il pregio del backprop è che aggiorna OGNI singolo parametro in proporzione a quanto influisce sulla perdita. Questo è possibile solo se sai come cambiare ogni parametro influisce sulla funzione di perdita.

Ma ovviamente con RL non è così: l'ambiente (e la ricompensa che produce) è un sistema completamente separato. Non hai una funzione continua e differenziabile che ti dica quanto il cambiamento di ogni parametro influisce sulla probabilità di cadere da un dirupo.

Le soluzioni sono piuttosto ingegnose! Ecco alcuni modi per trovare un proxy differenziabile per la ricompensa:

Metodi di gradiente della politica: Non puoi differenziare la ricompensa rispetto alla rete. Ma puoi differenziare le probabilità di diverse azioni/token suggeriti dalla rete. Quindi basta fare in modo che la perdita = la (somma dei log negativi) delle probabilità PESATE dalla ricompensa. La perdita è più alta quando la ricompensa è più bassa, quindi il modello impara a produrre token che portano a una ricompensa più alta con una probabilità maggiore.

Q-learning: Ancora una volta, la ricompensa non è differenziabile rispetto alla rete. Ma sai cosa lo è? La previsione della ricompensa da parte della rete. E puoi aggiornarla in base a quanto era errata quella previsione. Ora che puoi prevedere quali azioni porteranno a quale ricompensa, la tua politica può semplicemente essere quella di intraprendere le azioni con la massima ricompensa attesa.

Principali

Ranking

Preferiti