Trendaavat aiheet

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

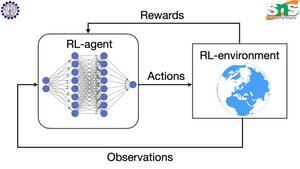

Miten taustatuki toimii RL:n kanssa?

Backpropin hyve on, että se päivittää JOKAISEN yksittäisen parametrin suhteessa siihen, kuinka paljon heiluttelua se vaikuttaa tappioon. Tämä on mahdollista vain, jos tiedät, miten kunkin parametrin muuttaminen vaikuttaa häviöfunktioon.

Mutta RL:n kohdalla näin ei tietenkään ole: ympäristö (ja sen tuottama palkkio) on kokonaan erillinen järjestelmä. Sinulla ei ole mitään jatkuvaa differentioituvaa funktiota, joka kertoo, kuinka paljon kunkin parametrin heiluminen vaikuttaa jyrkänteeltä putoamisen todennäköisyyteen.

Ratkaisut ovat varsin älykkäitä! Tässä on joitain tapoja keksiä eriytettävä palkkion välityspalvelin:

Käytännön gradienttimenetelmät: Et voi erottaa palkkiota verkon suhteen. Mutta voit erottaa verkon ehdottamien eri toimintojen/tokenien todennäköisyydet. Joten tee vain tappio = (negatiivisen login summa) todennäköisyydet PAINOTETTUNA palkkiolla. Tappio on suurempi, kun palkkio on pienempi, joten malli oppii tuottamaan tokeneita, jotka johtavat korkeampaan palkkioon suuremmalla todennäköisyydellä.

K-oppiminen: Jälleen kerran, palkitseminen ei ole eriytettavissa suhteessa verkostoon. Mutta tiedätkö mikä on? Verkoston ennuste palkkiosta. Ja voit päivittää sen sen perusteella, kuinka väärä ennuste oli. Nyt kun voit ennustaa, mitkä toimet johtavat mihinkin palkkioon, politiikkasi voi yksinkertaisesti olla vain korkeimpien odotettujen palkkioiden toteuttaminen.

Johtavat

Rankkaus

Suosikit