Tendencias del momento

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

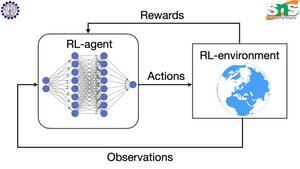

¿Cómo funciona el backprop con RL?

La virtud del backprop es que actualiza CADA parámetro individual en proporción a cuánto afecta la pérdida. Esto solo es posible si sabes cómo cambiar cada parámetro afecta la función de pérdida.

Pero, por supuesto, con RL esto no es el caso: el entorno (y la recompensa que produce) es un sistema completamente separado. No tienes una función continua y diferenciable que te diga cuánto afecta cada parámetro a la probabilidad de caer por un acantilado.

¡Las soluciones son bastante ingeniosas! Aquí hay algunas formas de encontrar un proxy diferenciable para la recompensa:

Métodos de gradiente de política: No puedes diferenciar la recompensa con respecto a la red. Pero puedes diferenciar las probabilidades de diferentes acciones/tokens sugeridos por la red. Así que simplemente haz que la pérdida = la (suma de logaritmos negativos) de las probabilidades PESADAS por la recompensa. La pérdida es mayor cuando la recompensa es menor, por lo que el modelo aprende a emitir tokens que conducen a una mayor recompensa con mayor probabilidad.

Q-learning: Nuevamente, la recompensa no es diferenciable con respecto a la red. Pero, ¿sabes qué sí lo es? La predicción de la recompensa de la red. Y puedes actualizarla en función de cuán errónea fue esa predicción. Ahora que puedes predecir qué acciones llevarán a qué recompensa, tu política puede simplemente ser tomar las acciones de mayor recompensa esperada.

Parte superior

Clasificación

Favoritos