Chủ đề thịnh hành

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

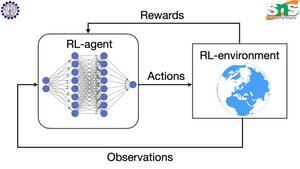

Backprop hoạt động như thế nào với RL?

Điểm mạnh của backprop là nó cập nhật TỪNG tham số riêng lẻ theo tỷ lệ với mức độ ảnh hưởng của nó đến tổn thất. Điều này chỉ có thể xảy ra nếu bạn biết cách thay đổi từng tham số ảnh hưởng đến hàm tổn thất như thế nào.

Nhưng tất nhiên với RL thì không phải như vậy: môi trường (và phần thưởng mà nó tạo ra) là một hệ thống hoàn toàn riêng biệt. Bạn không có một hàm liên tục khả vi nào cho bạn biết mức độ ảnh hưởng của từng tham số đến xác suất rơi xuống vực.

Các giải pháp rất thông minh! Dưới đây là một số cách để tạo ra một proxy khả vi cho phần thưởng:

Phương pháp gradient chính sách: Bạn không thể phân biệt phần thưởng theo mạng. Nhưng bạn có thể phân biệt xác suất của các hành động/tokens khác nhau được gợi ý bởi mạng. Vì vậy, chỉ cần làm cho tổn thất = (tổng của log âm) xác suất ĐƯỢC CÂN NHẮC bởi phần thưởng. Tổn thất cao hơn khi phần thưởng thấp hơn, vì vậy mô hình học cách xuất ra các tokens dẫn đến phần thưởng cao hơn với xác suất cao hơn.

Q-learning: Một lần nữa, phần thưởng không khả vi theo mạng. Nhưng bạn biết điều gì khả vi? Dự đoán của mạng về phần thưởng. Và bạn có thể cập nhật nó dựa trên mức độ sai lệch của dự đoán đó. Bây giờ bạn có thể dự đoán những hành động nào sẽ dẫn đến phần thưởng nào, chính sách của bạn có thể đơn giản chỉ là thực hiện các hành động có phần thưởng kỳ vọng cao nhất.

Hàng đầu

Thứ hạng

Yêu thích