Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

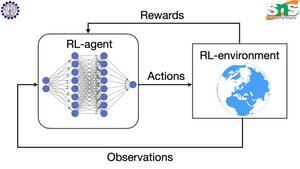

Comment fonctionne le backprop avec le RL ?

La vertu du backprop est qu'il met à jour CHAQUE paramètre individuel en proportion de l'impact qu'il a sur la perte. Cela n'est possible que si vous savez comment le changement de chaque paramètre affecte la fonction de perte.

Mais bien sûr, avec le RL, ce n'est pas le cas : l'environnement (et la récompense qu'il produit) est un système complètement séparé. Vous n'avez pas de fonction continue et différentiable qui vous indique combien le changement de chaque paramètre affecte la probabilité de tomber d'une falaise.

Les solutions sont assez astucieuses ! Voici quelques façons de trouver un proxy différentiable pour la récompense :

Méthodes de gradient de politique : Vous ne pouvez pas différencier la récompense par rapport au réseau. Mais vous pouvez différencier les probabilités des différentes actions/tokens suggérés par le réseau. Donc, il suffit de faire en sorte que la perte = la (somme des logarithmes négatifs) des probabilités PONDÉRÉES par la récompense. La perte est plus élevée lorsque la récompense est plus basse, donc le modèle apprend à produire des tokens qui mènent à une récompense plus élevée avec une probabilité plus élevée.

Q-learning : Encore une fois, la récompense n'est pas différentiable par rapport au réseau. Mais savez-vous ce qui l'est ? La prédiction de la récompense par le réseau. Et vous pouvez la mettre à jour en fonction de l'erreur de cette prédiction. Maintenant que vous pouvez prédire quelles actions mèneront à quelle récompense, votre politique peut simplement consister à prendre les actions avec la plus haute récompense attendue.

Meilleurs

Classement

Favoris