Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

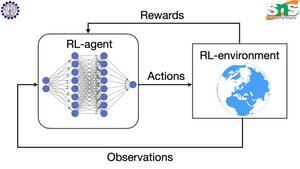

Jak działa backprop w RL?

Zaletą backprop jest to, że aktualizuje KAŻDY pojedynczy parametr w proporcji do tego, jak bardzo jego zmiana wpływa na stratę. Jest to możliwe tylko wtedy, gdy wiesz, jak zmiana każdego parametru wpływa na funkcję straty.

Ale oczywiście w przypadku RL tak nie jest: środowisko (i nagroda, którą produkuje) to całkowicie oddzielny system. Nie masz jakiejś ciągłej różniczkowalnej funkcji, która mówi ci, jak bardzo zmiana każdego parametru wpływa na prawdopodobieństwo spadnięcia z klifu.

Rozwiązania są dość sprytne! Oto kilka sposobów na opracowanie różniczkowalnego proxy dla nagrody:

Metody gradientu polityki: Nie możesz różniczkować nagrody względem sieci. Ale możesz różniczkować prawdopodobieństwa różnych działań/tokenów sugerowanych przez sieć. Więc po prostu zrób stratę = (suma negatywnego logarytmu) prawdopodobieństw WAŻONYCH przez nagrodę. Strata jest wyższa, gdy nagroda jest niższa, więc model uczy się generować tokeny, które prowadzą do wyższej nagrody przy wyższym prawdopodobieństwie.

Q-learning: Ponownie, nagroda nie jest różniczkowalna względem sieci. Ale wiesz, co jest? Prognoza nagrody przez sieć. I możesz ją zaktualizować na podstawie tego, jak bardzo ta prognoza była błędna. Teraz, gdy możesz przewidzieć, jakie działania doprowadzą do jakiej nagrody, twoja polityka może po prostu polegać na podejmowaniu działań o najwyższej oczekiwanej nagrodzie.

Najlepsze

Ranking

Ulubione