热门话题

#

Bonk 生态迷因币展现强韧势头

#

有消息称 Pump.fun 计划 40 亿估值发币,引发市场猜测

#

Solana 新代币发射平台 Boop.Fun 风头正劲

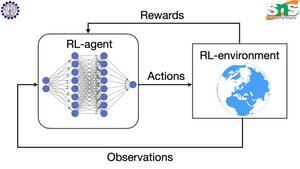

反向传播在强化学习中是如何工作的?

反向传播的优点在于它根据每个参数对损失的影响程度来更新每个单独的参数。这只有在你知道改变每个参数如何影响损失函数的情况下才有可能。

但在强化学习中情况并非如此:环境(以及它产生的奖励)是一个完全独立的系统。你没有某个连续可微的函数来告诉你每个参数的微小变化对掉下悬崖的概率有多大影响。

解决方案非常巧妙!以下是一些为奖励提供可微代理的方法:

策略梯度方法:你无法对网络的奖励进行微分。但你可以对网络建议的不同动作/标记的概率进行微分。因此,只需将损失设置为(负对数的总和)乘以奖励的加权。奖励越低,损失越高,因此模型学习输出导致更高奖励的标记,并且概率更高。

Q学习:同样,奖励与网络的关系不可微分。但你知道什么是可微分的?网络对奖励的预测。你可以根据该预测的错误程度来更新它。现在你可以预测哪些动作会导致什么奖励,你的策略可以简单地是采取预期奖励最高的动作。

热门

排行

收藏