Topik trending

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

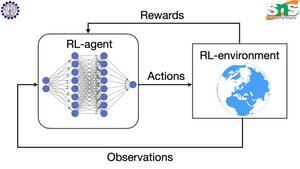

Bagaimana cara kerja backprop dengan RL?

Keunggulan backprop adalah memperbarui SETIAP parameter individu sebanding dengan seberapa banyak goyangannya memengaruhi kerugian. Ini hanya mungkin jika Anda tahu bagaimana mengubah setiap parameter memengaruhi fungsi kerugian.

Tapi tentu saja dengan RL ini tidak terjadi: lingkungan (dan imbalan yang dihasilkannya) adalah sistem yang sama sekali terpisah. Anda tidak memiliki fungsi yang dapat dibedakan terus menerus yang memberi tahu Anda seberapa banyak goyangan setiap parameter memengaruhi kemungkinan jatuh dari tebing.

Solusinya cukup pintar! Berikut adalah beberapa cara untuk membuat proxy yang dapat dibedakan untuk hadiah:

Metode gradien kebijakan: Anda tidak dapat membedakan reward sehubungan dengan jaringan. Tetapi Anda dapat membedakan probabilitas berbagai tindakan/token yang disarankan oleh jaringan. Jadi buat saja kerugian = probabilitas (jumlah log negatif) DITIMBANG oleh hadiah. Kerugian lebih tinggi ketika imbalan lebih rendah, sehingga model belajar untuk menghasilkan token yang mengarah pada imbalan yang lebih tinggi pada probabilitas yang lebih tinggi.

Q-learning: Sekali lagi, hadiah tidak dapat dibedakan sehubungan dengan jaringan. Tapi Anda tahu apa itu? Prediksi jaringan tentang hadiah. Dan Anda dapat memperbaruinya berdasarkan seberapa salah prediksi itu. Sekarang setelah Anda dapat memprediksi tindakan apa yang akan mengarah pada imbalan apa, kebijakan Anda hanya dapat mengambil tindakan imbalan tertinggi yang diharapkan.

Teratas

Peringkat

Favorit