Subiecte populare

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

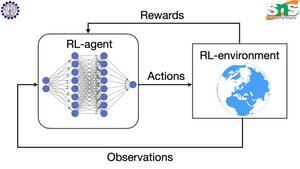

Cum funcționează backprop cu RL?

Virtutea backprop-ului este că actualizează FIECARE parametru individual proporțional cu cât de mult se mișcă afectează pierderea. Acest lucru este posibil numai dacă știți cum schimbarea fiecărui parametru afectează funcția de pierdere.

Dar, desigur, cu RL nu este cazul: mediul (și recompensa pe care o produce) este un sistem cu totul separat. Nu aveți o funcție diferențiabilă continuă care să vă spună cât de mult afectează fiecare parametru probabilitatea de a cădea de pe o stâncă.

Soluțiile sunt destul de inteligente! Iată câteva modalități de a veni cu un proxy diferențiabil pentru recompensă:

Metode de gradient al politicii: Nu puteți diferenția recompensa în raport cu rețeaua. Dar puteți diferenția probabilitățile diferitelor acțiuni/token-uri sugerate de rețea. Deci, faceți ca pierderea = probabilitățile (suma logaritmului negativ) PONDERATE de recompensă. Pierderea este mai mare atunci când recompensa este mai mică, astfel încât modelul învață să producă jetoane care duc la o recompensă mai mare cu o probabilitate mai mare.

Q-learning: Din nou, recompensa nu este diferențiabilă în ceea ce privește rețeaua. Dar știi ce este? Predicția rețelei cu privire la recompensă. Și îl puteți actualiza în funcție de cât de greșită a fost predicția. Acum că puteți prezice ce acțiuni vor duce la ce recompensă, politica dumneavoastră poate fi pur și simplu să luați cele mai mari acțiuni de recompensă așteptate.

Limită superioară

Clasament

Favorite