Актуальные темы

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

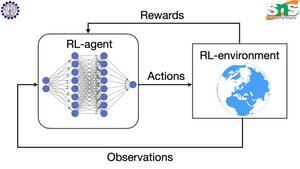

Как работает обратное распространение с RL?

Достоинство обратного распространения заключается в том, что оно обновляет КАЖДЫЙ отдельный параметр пропорционально тому, насколько его изменение влияет на потерю. Это возможно только в том случае, если вы знаете, как изменение каждого параметра влияет на функцию потерь.

Но, конечно, с RL это не так: окружающая среда (и вознаграждение, которое она производит) — это совершенно отдельная система. У вас нет непрерывной дифференцируемой функции, которая бы говорила вам, насколько изменение каждого параметра влияет на вероятность упасть с обрыва.

Решения довольно умные! Вот несколько способов придумать дифференцируемый прокси для вознаграждения:

Методы градиента политики: Вы не можете дифференцировать вознаграждение по отношению к сети. Но вы можете дифференцировать вероятности различных действий/токенов, предлагаемых сетью. Поэтому просто сделайте потерю = (сумма отрицательных логарифмов) вероятностей, ВЕСОВЫХ по вознаграждению. Потеря выше, когда вознаграждение ниже, поэтому модель учится выдавать токены, которые приводят к более высокому вознаграждению с более высокой вероятностью.

Q-обучение: Снова, вознаграждение не дифференцируемо по отношению к сети. Но вы знаете, что можно? Прогноз сети о вознаграждении. И вы можете обновить его на основе того, насколько ошибочным был этот прогноз. Теперь, когда вы можете предсказать, какие действия приведут к какому вознаграждению, ваша политика может просто заключаться в том, чтобы предпринимать действия с наивысшим ожидаемым вознаграждением.

Топ

Рейтинг

Избранное